Introdução

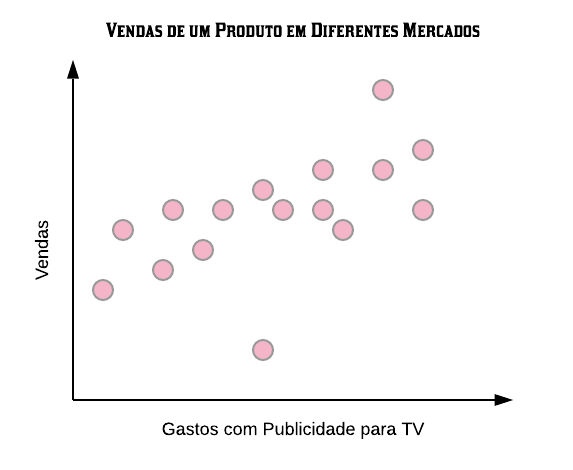

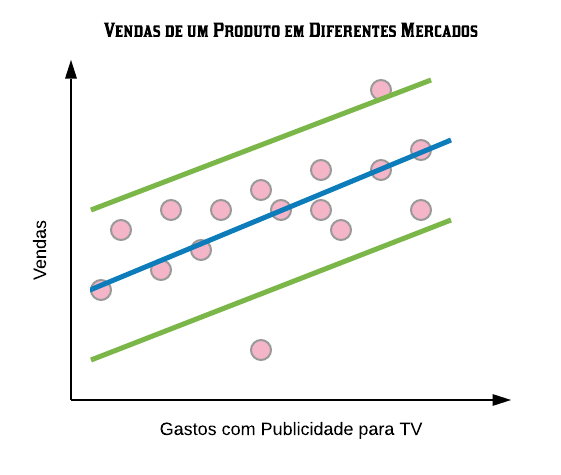

Este curso tem como objetivo propagar as ideias básicas de aprendizado de máquina e previsão no software estatístico R. A ideia principal é cobrir as técnicas mais usadas como regressão linear, árvores de decisão, e também detalhes básicos e aspectos práticos do aprendizado de máquina. Inicialmente será utilizado alguns códigos básicos do R para alguns modelos de previsão. Contudo, o foco principal será no pacote caret, o qual tem a finalidade de tornar as técnicas de aprendizado mais simples, combinando um grande número de preditores que foram construídos no R.

Pré-requisitos

Os pré-requisitos que serão úteis para o curso são: análise exploratória de dados no R, programação básica em R e conhecimentos teóricos básicos sobre modelos de regressão.

O que é o Aprendizado de Máquina?

Em 1959, Arthur Samuel definiu o aprendizado de máquina como o “campo de estudo que dá aos computadores a habilidade de aprender sem serem explicitamente programados”. Ou seja, é um método de análise de dados que automatiza a construção de modelos analíticos. É baseado na ideia de que sistemas podem aprender com dados, identificar padrões e tomar decisões com o mínimo de intervenção humana. A importância desse aprendizado se deve principalmente ao fato de que atualmente tem surgido cada vez mais a necessidade de manipulações de grandes volumes e variedades de dados disponíveis.

Para que serve?

Com o aprendizado de máquina é possível produzir, rápida e automaticamente, modelos capazes de analisar dados maiores e mais complexos, e entregar resultados mais rápidos e precisos – mesmo em grande escala.

Onde é usado?

Ao construir modelos precisos há mais chances de identificar boas oportunidades e de evitar riscos desconhecidos. Na prática, podemos citar alguns exemplos reais do uso de aprendizado de máquina:

- Os governos locais podem tentar prever os pagamentos de pensão no futuro para que eles saibam se seus mecanismos de geração de receita têm fundos suficientes gerados para cobrir esses pagamentos de pensão.

- O Google pode querer prever se você vai clicar em um anúncio para que ele possa mostrar apenas os anúncios com maior probabilidade de receber cliques e, assim, aumentar a receita.

- A Amazon, a Netflix e outras empresas como essa mostram um filme e querem que você veja um próximo filme. Para fazer isso, eles querem mostrar a você o que você pode estar interessado, para que eles possam mantê-lo assistindo e, novamente, aumentar a receita.

- As seguradoras empregam grandes grupos de atuários e estatísticos para tentar prever seu risco de todo tipo de coisas diferentes, como por exemplo a morte.

Como funciona?

A funcionalidade do aprendizado de máquina se resume a tentar prever um certo modelo para o conjunto de dados em questão. Há dois modos de isso ser feito: pelo aprendizado supervisionado e pelo aprendizado não supervisionado. Veremos a definição de cada um deles a seguir.

Tipos de Aprendizado de Maquina

Aprendizado não supervisionado

Na aprendizagem não supervisionada, temos um conjunto de dados não rotulados e queremos de alguma forma agrupá-los por um certo padrão encontrado. Vejamos alguns exemplos:

- Exemplo 1: Dada uma imagem de homem/mulher, temos de prever sua idade com base em dados da imagem.

- Exemplo 2: Dada as informações sobre que músicas uma pessoa costuma ouvir, sugerir outras que possam agradá-la também.

Aprendizado supervisionado

No aprendizado supervisionado, por outro lado, temos um conjunto de dados já rotulados que sabemos qual é a nossa saída correta e que deve ser semelhante ao conjunto. Queremos assim, com base nesses dados, ser capaz de classificar outros dados do mesmo tipo e que ainda não foram rotulados.

- Exemplo 1: Dada uma coleção de 1000 pesquisas de uma universidade, encontrar uma maneira de agrupar automaticamente estas pesquisas em grupos que são de alguma forma semelhantes ou relacionadas por diferentes variáveis, tais como a frequência das palavras, frases, contagem de páginas, etc.

- Exemplo 2: Dada uma grande amostra de e-mails, encontrar uma maneira de agrupá-los automaticamente em “spam” ou “não spam”, de acordo com as características das palavras, tais como a frequência com que uma certa palavra aparece, a frequência de letras maiúsculas, de cifrões ($), entre outros.

Se os valores da variável rótulo, também chamada de variável de interesse, são valores discretos finitos ou ainda categóricos, então temos um problema de classificação e o algoritmo que criaremos para resolver nosso problema será chamado Classificador.

Se os valores da Variável de Interesse são valores contínuos, então temos um problema de regressão e o algoritmo que criaremos será chamado Regressor.

A aprendizagem supervisionada será o principal foco do curso.

Predição

Queremos então construir um algoritmo “preditor” capaz de inferir se um dado pertence ou não a uma certa categoria. O preditor será formado dos seguintes componentes:

Pergunta $\rightarrow$ Amostra de entrada $\rightarrow$ Características $\rightarrow$ Algoritmo $\rightarrow$ Parâmetros $\rightarrow$ Avaliação

Pergunta

O nosso objetivo é responder a uma pergunta de tipo “O dado A é do tipo x ou do tipo y?”. Por exemplo, podemos querer saber se é possível detectar automaticamente se um e-mail é um spam ou um “ham”, isto é, não spam. O que na verdade queremos saber é: “É possível usar características quantitativas para classificar um e-mail como spam?”.

Amostra de Entrada

Uma vez formulada a pergunta, precisamos obter uma amostra de onde tentaremos extrair informações que caracterizam a categoria a qual um dado pertence e então usar essas informações para classificar outros dados não categorizados. O ideal é que se tenha uma amostra grande, assim teremos melhores parâmetros para construir nosso preditor.

No caso da pergunta sobre um e-mail ser spam ou não, temos acesso a base de dados “spam” disponível no pacote “kernlab”, onde cada linha dessa base é um e-mail e nas colunas temos a porcentagem de palavras e números contidos em cada e-mail e, entre outras coisas, a nossa variável de interesse “type” que classifica o e-mail como spam ou não:

library(kernlab)

data(spam)

head(spam)

## make address all num3d our over remove internet order mail receive will people report addresses free business email

## 1 0.00 0.64 0.64 0 0.32 0.00 0.00 0.00 0.00 0.00 0.00 0.64 0.00 0.00 0.00 0.32 0.00 1.29

## 2 0.21 0.28 0.50 0 0.14 0.28 0.21 0.07 0.00 0.94 0.21 0.79 0.65 0.21 0.14 0.14 0.07 0.28

## 3 0.06 0.00 0.71 0 1.23 0.19 0.19 0.12 0.64 0.25 0.38 0.45 0.12 0.00 1.75 0.06 0.06 1.03

## 4 0.00 0.00 0.00 0 0.63 0.00 0.31 0.63 0.31 0.63 0.31 0.31 0.31 0.00 0.00 0.31 0.00 0.00

## 5 0.00 0.00 0.00 0 0.63 0.00 0.31 0.63 0.31 0.63 0.31 0.31 0.31 0.00 0.00 0.31 0.00 0.00

## 6 0.00 0.00 0.00 0 1.85 0.00 0.00 1.85 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

## you credit your font num000 money hp hpl george num650 lab labs telnet num857 data num415 num85 technology num1999

## 1 1.93 0.00 0.96 0 0.00 0.00 0 0 0 0 0 0 0 0 0 0 0 0 0.00

## 2 3.47 0.00 1.59 0 0.43 0.43 0 0 0 0 0 0 0 0 0 0 0 0 0.07

## 3 1.36 0.32 0.51 0 1.16 0.06 0 0 0 0 0 0 0 0 0 0 0 0 0.00

## 4 3.18 0.00 0.31 0 0.00 0.00 0 0 0 0 0 0 0 0 0 0 0 0 0.00

## 5 3.18 0.00 0.31 0 0.00 0.00 0 0 0 0 0 0 0 0 0 0 0 0 0.00

## 6 0.00 0.00 0.00 0 0.00 0.00 0 0 0 0 0 0 0 0 0 0 0 0 0.00

## parts pm direct cs meeting original project re edu table conference charSemicolon charRoundbracket

## 1 0 0 0.00 0 0 0.00 0 0.00 0.00 0 0 0.00 0.000

## 2 0 0 0.00 0 0 0.00 0 0.00 0.00 0 0 0.00 0.132

## 3 0 0 0.06 0 0 0.12 0 0.06 0.06 0 0 0.01 0.143

## 4 0 0 0.00 0 0 0.00 0 0.00 0.00 0 0 0.00 0.137

## 5 0 0 0.00 0 0 0.00 0 0.00 0.00 0 0 0.00 0.135

## 6 0 0 0.00 0 0 0.00 0 0.00 0.00 0 0 0.00 0.223

## charSquarebracket charExclamation charDollar charHash capitalAve capitalLong capitalTotal type

## 1 0 0.778 0.000 0.000 3.756 61 278 spam

## 2 0 0.372 0.180 0.048 5.114 101 1028 spam

## 3 0 0.276 0.184 0.010 9.821 485 2259 spam

## 4 0 0.137 0.000 0.000 3.537 40 191 spam

## 5 0 0.135 0.000 0.000 3.537 40 191 spam

## 6 0 0.000 0.000 0.000 3.000 15 54 spam

Obtida a amostra, precisamos dividi-la em duas partes que chamaremos de Conjunto de Treino e Conjunto de Teste. O conjunto de treino será usado para construir o algoritmo. É dele que vamos extrair as informações que julgarmos utéis para classificar uma categoria de dado. É importante que o modelo de previsão seja feito com base apenas no conjunto de treino.

set.seed(127)

indices = sample(dim(spam)[1], size = 2760)

treino = spam[indices,]

teste = spam[-indices,]

Após construido o algoritmo, usaremos o conjunto de teste para obter a estimativa de erro, que será detalhada mais a frente.

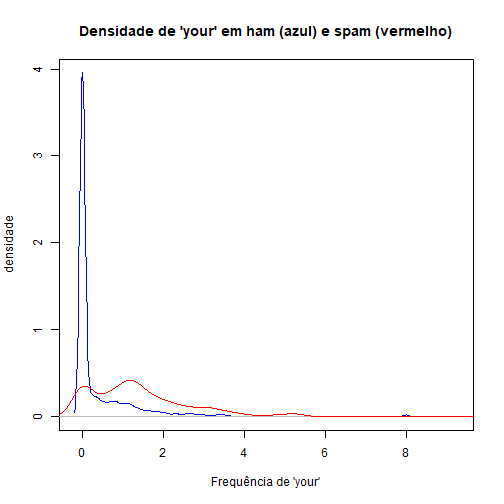

Características

Temos que encontrar agora características que possam indicar a categoria dos dados. Podemos, por exemplo, vizualizar algumas variáveis graficamente para obter uma ideia do que podemos fazer. No nosso exemplo de e-mails, podemos querer avaliar se a frequência de palavras “your” em um e-mail pode indicar se ele é um spam ou não.

plot(density(treino$your[treino$type=="nonspam"]), col="blue",

main = "Densidade de 'your' em ham (azul) e spam (vermelho)",

xlab = "Frequência de 'your'", ylab = "densidade")

lines(density(treino$your[treino$type=="spam"]), col="red")

Pelo gráfico podemos notar que a maioria dos e-mails que são spam têm uma frequência maior da palavra “your”. Por outro lado, aqueles que são classificados como ham (não spam) têm um pico mais alto perto do 0.

Algoritmo

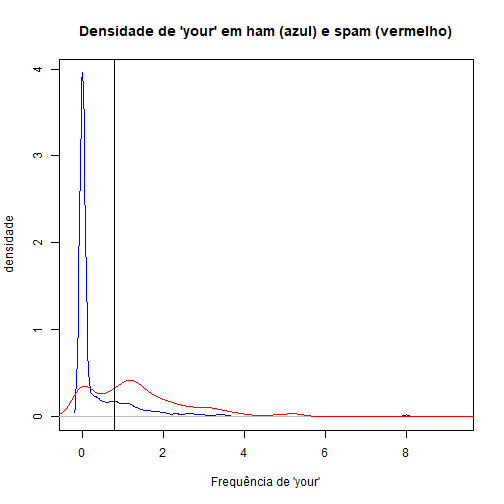

Com base nisso podemos construir um algoritmo para prever se um e-mail é spam ou ham. Podemos estimar um modelo onde queremos encontrar uma constante c tal que se a frequência da palavra “your” for maior que c, então classificamos o e-mail como spam. Caso contrário, classificamos o e-mail como não spam.

Vamos observar graficamente como ficaria esse modelo se c=0.8.

plot(density(treino$your[treino$type=="nonspam"]), col="blue",

main = "Densidade de 'your' em ham (azul) e spam (vermelho)",

xlab = "Frequência de 'your'", ylab = "densidade")

lines(density(treino$your[treino$type=="spam"]), col="red")

abline(v=0.8,col="black")

Os e-mails à direita da linha preta seriam classificados como spam, enquanto que os à esquerda seriam classificados como não spam.

Avaliação

Agora vamos avaliar nosso modelo de predição.

predicao=ifelse(treino$your>0.8,"spam","nonspam")

table(predicao,treino$type)/length(treino$type)

##

## predicao nonspam spam

## nonspam 0.4978261 0.1293478

## spam 0.1155797 0.2572464

Podemos ver que quando os e-mails não eram spam e classificamos como “não spam”, de acordo com nosso modelo, em 50% do tempo nós acertamos. Quando os e-mails eram spam e classificamos ele em spam, por volta de 26% do tempo nós acertamos. Então, ao total, nós acertamos por volta de 50+26=76% do tempo. Então nosso algoritmo de previsão tem uma precisão por volta de 76% na amostra treino.

predicao=ifelse(teste$your>0.8,"spam","nonspam")

table(predicao,teste$type)/length(teste$type)

##

## predicao nonspam spam

## nonspam 0.4910375 0.1434003

## spam 0.1037480 0.2618142

Já na amostra teste acertamos 48+27=75% das vezes. O erro na amostra teste é o que chamamos de erro real. É o erro que esperamos em amostras novas que passarem por nosso preditor.

Como construir um bom algoritmo de aprendizado de máquina?

O “melhor” método de aprendizado de máquina é caracterizado por:

- Uma boa base de dados;

- Reter informações relevantes;

- Ser bem interpretável;

- Fácil de ser explicado e entendido;

- Ser preciso;

- Fácil de se construir e de se testar em pequenas amostras;

- Fácil aplicar a um grande conjunto de dados.

Os erros mais comuns, que se deve tomar um certo cuidado, são:

- Tentar automatizar a seleção de variáveis (características) de uma maneira que não permita que você entenda como essas variáveis estão sendo aplicadas para fazer previsões;

- Não prestar atenção a peculiaridades específicas de alguns dados, como comportamentos estranhos de variáveis específicas;

- Jogar fora informações desnecessariamente.

Design de predição

1. Defina sua taxa de erro (benchmark).

Por hora iremos utilizar uma taxa de erro genérica, mas em um próximo iremos falar sobre quais são as diferentes taxas de erro possíveis que você pode escolher.

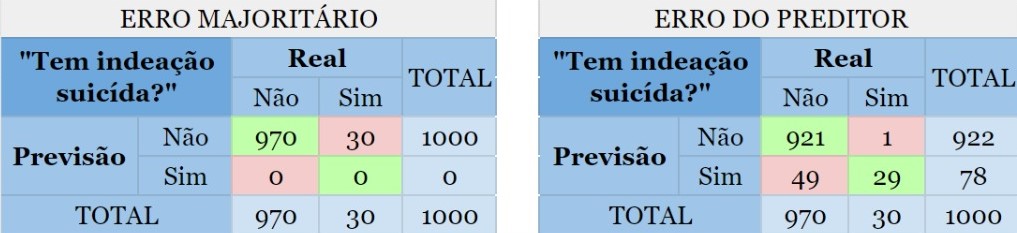

Por exemplo, podemos calcular o chamado erro majoritário que é o limite máximo abaixo do qual o erro de um classificador deve estar. Ele é dado por $1-p$, onde $p$ é a proporção da categoria mais requente na variável de interesse. Por exemplo, se a variável de interesse possui 2 categorias: A e B. Se $85\%$ dos dados estão rotulados na categoria A e $15\%$ na categoria B, entao temos que a categoria A é a classe majoritária e $100\%-85\% = 15\%$ é o erro majoritário.

Caso o erro do preditor seja superior ao erro majoritário, seria melhor classificar toda nova amostra na classe majoritária, certo? Depende.

Digamos que um psicólogo quer construir um classificador para prever se uma pessoa tem ou não indeação suicida, ou seja, pensa ou planeja suicídio. Suponha que ele tem uma base de dados com 1000 observações cuja variável de interesse “Tem indeação suicida?” está rotulada com “sim” ou “não” e 97% das observações, no caso indivíduos/pacientes, não possuem tal característica e portanto 3% dos indivíduos possuem. Criado o preditor, observamos que o erro é de 5%, assim como mostrado a seguir:

As partes em vermelho mostram o erro cometido por ambos os métodos. Agora note as pessoas que possuem indeação suicída porém foram classficadas como não possuidoras dessa característica. Quanto isso afetará no dignóstico do psicólogo?

2. Divida os dados em Treino e Teste, ou Treino, Teste e Validação (opcional).

Como já comentado, o conjunto de treino deve ser criado para construir seu modelo e o conjunto de testes para avaliar seu modelo. Fazemos isso com o intuito de criarmos um modelo que se ajuste bem a qualquer base de dados, e não apenas à nossa. É comum usar 70% da amostra como treino e 30% como teste, mas isso não é uma regra. Podemos também repartir os dados em treino, teste e validação(*). É importante ficar claro que quem está conduzindo as análises é quem fica encarregado de decidir o que fica melhor para cada amostra.

3. Definimos quais variáveis serão utilizadas para estimação dos parâmetros do classificador/regressor (função preditora).

Nem sempre utilizar todas as variáveis do banco de dados é importante para o modelo. Pode acontecer de termos variáveis que não ajudam na predição, como por exemplo aquelas com uma variância quase zero (frequência muito alta de um único valor). Iremos estudar algumas formas de selecionar as melhores variáveis para o modelo em breve.

4. Definimos o método que será utilizado para construção do classificador/regressor.

Isso poderá ser feito, por exemplo, utilizando o método de validação cruzada (cross-validation), que será explicado detalhadamente em um capítulo mais à frente.

5. Utilizando a amostra TREINO, definimos os parâmetros da função preditora (classificador/regressor), obtendo o melhor modelo possível.

6. Aplicamos o melhor modelo obtido na amostra TESTE uma única vez, para estimar o erro do preditor.

Aplicamos o melhor modelo na amostra teste apenas uma vez porque se aplicarmos diversas vezes até achar o melhor modelo estaremos utilizando o teste, de certa forma, para treinar o modelo, pois o ajuste do modelo seria influenciado pelo resultado do teste. Isso não é desejável pois o objetivo do teste é nos servir como uma “nova amostra”.

(*) Opcionalmente poderá ser criado um conjunto de validação, com o intuito de servir como um “pré-teste”, que também será usado para avaliar seu modelo. Quando repartimos o conjunto de dados dessa forma, utilizamos o treino para construir o modelo, avaliamos o modelo na validação (ou seja, o ajuste do modelo é influenciado por ela), e se o resultado não for bom, retornamos ao treino para ajustar um outro modelo. Então novamente testamos o modelo na validação, e assim sucessivamente até acharmos um modelo que se adequou bem tanto ao treino quanto à validação. Aí, finalmente, aplicamos ele ao conjunto teste, avaliando na prática a sua qualidade.

Erros Amostrais

Este é um dos conceitos mais fundamentais com os quais lidamos na aprendizagem de máquina e previsão. Temos duas taxas de erros amostrais: o erro dentro da amostra (in sample error) e o erro fora da amostra (out of sample error).

Erro dentro da Amostra (In Sample Error)

É a taxa de erro que você recebe no mesmo conjunto de dados usado para criar seu preditor. Na literatura às vezes é chamado de erro de resubstituição. Em outras palavras, é quando seu algoritmo de previsão se ajusta ao que você coletou num conjunto de dados específico. E assim, quando você recebe um novo conjunto de dados, a precisão diminuirá.

Erro fora da Amostra (Out of Sample Error)

É a taxa de erro que você recebe em um novo conjunto de dados. Na literatura às vezes é chamado de erro de generalização. Uma vez que coletamos uma amostra de dados e construímos um modelo para ela, podemos querer testá-lo em uma nova amostra, por exemplo uma amostra coletada em um horário diferente ou em um local diferente. Daí podemos analisar o quão bem o algoritmo executará a predição nesse novo conjunto de dados.

Algumas ideias-chave

- Quase sempre o erro fora da amostra é o que interessa.

- Erro dentro da amostra é menor que o erro fora da amostra.

- Um erro frequente é ajustar muito o algoritmo aos dados que temos. Em outras palavras, criar um modelo overfitting(*).

(*) Overfitting é um termo usado na estatística para descrever quando um modelo estatístico se ajusta muito bem a um conjunto de dados anteriormente observado e, como consequência, se mostra ineficaz para prever novos resultados.

Vejamos um exemplo de erro dentro da amostra vs erro fora da amostra:

set.seed(131)

# Vamos selecionar as linhas da base de dados spam através de uma amostra de tamanho 10 das 4601 linhas

# dos dados:

spamMenor = spam[sample(dim(spam)[1], size = 10), ]

# Vamos criar um vetor composto pelos rótulos "1" e "2".

# Se um e-mail da nossa amostra for spam, recebe "1", se não for spam, recebe "2".

spamRotulos = (spamMenor$type == "spam")*1 + 1

# Na nossa base a variável capitalAve representa a média de letras maiúsculas por linha.

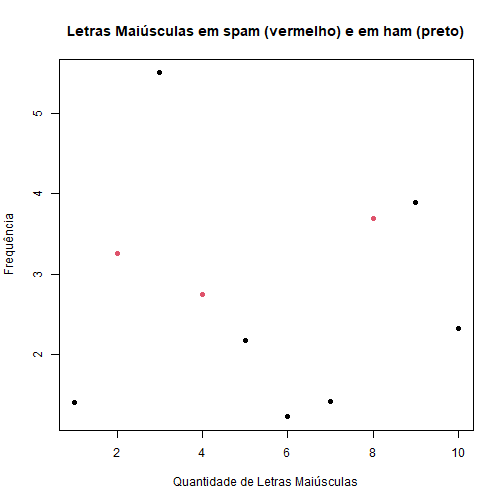

plot(spamMenor$capitalAve, col = spamRotulos, xlab = "Quantidade de Letras Maiúsculas",

ylab = "Frequência", main = "Letras Maiúsculas em spam (vermelho) e em ham (preto)",

pch = 19)

Podemos notar que, em geral, as mensagens classificadas como spam possuem uma frequência maior de letras maiúsculas do que as mensagens classificadas como não spam. Com base nisso queremos construir um preditor, onde podemos classificar e-mails como spam se a frequência de letras maiúsculas for maior que uma determida constante, e não spam caso contrário.

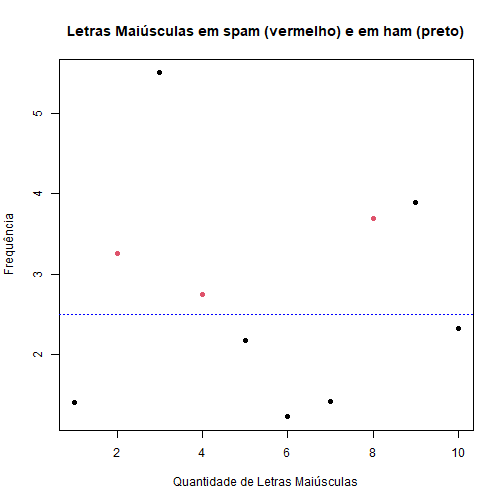

Veja que se separarmos os dados pela frequência de letras maiúsculas maior que 2,5 e classificarmos o que está acima como spam e abaixo como não spam, ainda teríamos duas observações que não são spam acima da linha.

plot(spamMenor$capitalAve, col = spamRotulos, xlab = "Quantidade de Letras Maiúsculas",

ylab = "Frequência", main = "Letras Maiúsculas em spam (vermelho) e em ham (preto)",

pch = 19)

abline(h = 2.5, lty = 3, col = "blue")

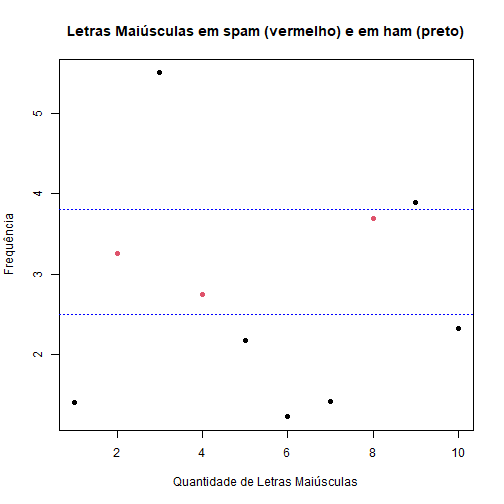

Então o melhor para esse caso é criar o seguinte modelo:

- letras maiúsculas > 2,5 e < 3,8 $\Rightarrow$ spam;

- letras maiúsculas < 2,5 ou > 3,8 $\Rightarrow$ não spam.

plot(spamMenor$capitalAve, col = spamRotulos, xlab = "Quantidade de Letras Maiúsculas",

ylab = "Frequência", main = "Letras Maiúsculas em spam (vermelho) e em ham (preto)",

pch = 19)

abline(h = c(2.5, 3.8), lty = 3, col = "blue")

# construindo o modelo sobreajustado

modelo.sobreajustado = function(x){

predicao = rep(NA, length(x))

predicao[(x>=2.5 & x<=3.8)] = "spam"

predicao[(x<2.5 | x>3.8)] = "nonspam"

return(predicao)

}

# avaliando o modelo sobreajustado

resultado = modelo.sobreajustado(spamMenor$capitalAve)

table(resultado, spamMenor$type)

##

## resultado nonspam spam

## nonspam 7 0

## spam 0 3

Note que obtivemos uma precisão perfeita nessa amostra, como já era esperado. Nesse caso, o erro dentro da amostra é de 0%. Mas será que esse modelo é o mais eficiente em outros dados também?

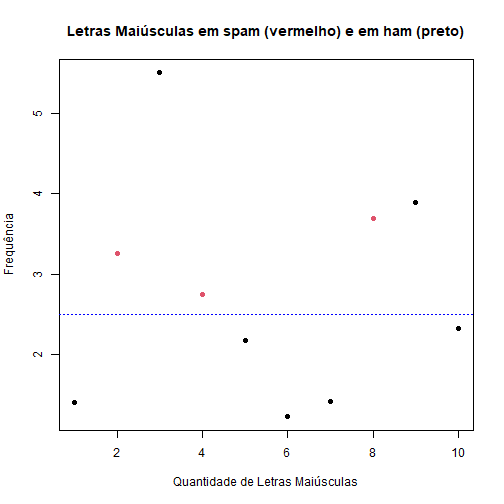

Vamos usar essa segunda regra para criarmos um modelo mais geral:

- letras maiúsculas > 2,5 $\Rightarrow$ spam;

- letras maiúsculas <= 2,5 $\Rightarrow$ não spam.

plot(spamMenor$capitalAve, col = spamRotulos, xlab = "Quantidade de Letras Maiúsculas",

ylab = "Frequência", main = "Letras Maiúsculas em spam (vermelho) e em ham (preto)",

pch = 19)

abline(h = 2.5, lty = 3, col = "blue")

# construindo o modelo geral

modelo.geral = function(x){

predicao = rep(NA, length(x))

predicao[x>=2.5] = "spam"

predicao[x<2.5] = "nonspam"

return(predicao)

}

# avaliando o modelo geral

resultado2 = modelo.geral(spamMenor$capitalAve)

table(resultado2, spamMenor$type)

##

## resultado2 nonspam spam

## nonspam 5 0

## spam 2 3

Observe que dessa forma temos um erro dentro da amostra de 20%. Vamos agora aplicar esses dois modelos para toda a base de dados:

table(modelo.sobreajustado(spam$capitalAve), spam$type)

##

## nonspam spam

## nonspam 2297 1385

## spam 491 428

table(modelo.geral(spam$capitalAve), spam$type)

##

## nonspam spam

## nonspam 2042 540

## spam 746 1273

Olhando para a precisão de nossos modelos:

sum(modelo.sobreajustado(spam$capitalAve) == spam$type)

## [1] 2725

sum(modelo.geral(spam$capitalAve) == spam$type)

## [1] 3315

Observe que utilizando o modelo sobreajustado obtivemos um erro fora da amostra de 40,77%, enquanto que com o modelo geral esse erro foi de 27,95%. Note que se queremos construir um modelo que melhor representa qualquer amostra que pegarmos, um modelo não sobreajustado possuirá uma precisão maior.

Avaliando Preditores - Introdução ao Pacote Caret

O pacote caret (abreviação de Classification And Regression Training) é um pacote muito útil para o machine learning pois envolve algoritmos que possibilitam que as previsões sejam feitas de forma mais prática, simplificando o processo de criação de modelos preditivos. Neste guia detalhado pode ser encontrado mais informações sobre o pacote.

Avaliando Classificadores

Vamos utilizar a base de dados spam novamente para realizarmos o procedimento de predição para um e-mail (se ele é spam ou não spam), dessa vez utilizando o pacote caret.

Para fazer a separação da amostra em treino e teste vamos primeiramente particionar a base de dados com a função createDataPartition().

library(caret)

library(kernlab)

data(spam)

set.seed(371)

noTreino = createDataPartition(y = spam$type, p = 0.75, list = F)

Essa função retorna os números das linhas a serem selecionadas para o treino. Os principais argumentos são:

- y = classe dos dados que deverá ser mantida a mesma proporção nos conjuntos treino e teste. Para o nosso exemplo, escolhemos manter a mesma proporção do tipo do e-mail. Sendo assim, tanto no treino como no teste teremos a mesma proporção de e-mails spam e não spam.

- p = porcentagem da amostra que será utilizada para o treino. Para o nosso exemplo, escolhemos 75%.

- list = argumento do tipo logical, se TRUE $\rightarrow$ os resultados serão mostrados em uma lista, se FALSE $\rightarrow$ os resultados serão mostrados em uma matriz.

OBS: Esse comando deve ser utilizado apenas quando os dados são amostras independentes.

Agora vamos separar o que irá para o treino e o que irá para o teste.

# Separando as linhas para o treino:

treino = spam[noTreino,]

# Separando as linhas para o teste:

teste = spam[-noTreino,]

Dado que já foi feito a separação das amostras treino e teste, o próximo passo é realizarmos o treinamento. Para isso é preciso escolher um dos modelos para ser utilizado. Uma lista com todos os modelos implementados no pacote caret pode ser vista com o seguinte comando:

names(getModelInfo())

## [1] "ada" "AdaBag" "AdaBoost.M1" "adaboost" "amdai"

## [6] "ANFIS" "avNNet" "awnb" "awtan" "bag"

## [11] "bagEarth" "bagEarthGCV" "bagFDA" "bagFDAGCV" "bam"

## [16] "bartMachine" "bayesglm" "binda" "blackboost" "blasso"

## [21] "blassoAveraged" "bridge" "brnn" "BstLm" "bstSm"

## [26] "bstTree" "C5.0" "C5.0Cost" "C5.0Rules" "C5.0Tree"

## [31] "cforest" "chaid" "CSimca" "ctree" "ctree2"

## [36] "cubist" "dda" "deepboost" "DENFIS" "dnn"

## [41] "dwdLinear" "dwdPoly" "dwdRadial" "earth" "elm"

## [46] "enet" "evtree" "extraTrees" "fda" "FH.GBML"

## [51] "FIR.DM" "foba" "FRBCS.CHI" "FRBCS.W" "FS.HGD"

## [56] "gam" "gamboost" "gamLoess" "gamSpline" "gaussprLinear"

## [61] "gaussprPoly" "gaussprRadial" "gbm_h2o" "gbm" "gcvEarth"

## [66] "GFS.FR.MOGUL" "GFS.LT.RS" "GFS.THRIFT" "glm.nb" "glm"

## [71] "glmboost" "glmnet_h2o" "glmnet" "glmStepAIC" "gpls"

## [76] "hda" "hdda" "hdrda" "HYFIS" "icr"

## [81] "J48" "JRip" "kernelpls" "kknn" "knn"

## [86] "krlsPoly" "krlsRadial" "lars" "lars2" "lasso"

## [91] "lda" "lda2" "leapBackward" "leapForward" "leapSeq"

## [96] "Linda" "lm" "lmStepAIC" "LMT" "loclda"

## [101] "logicBag" "LogitBoost" "logreg" "lssvmLinear" "lssvmPoly"

## [106] "lssvmRadial" "lvq" "M5" "M5Rules" "manb"

## [111] "mda" "Mlda" "mlp" "mlpKerasDecay" "mlpKerasDecayCost"

## [116] "mlpKerasDropout" "mlpKerasDropoutCost" "mlpML" "mlpSGD" "mlpWeightDecay"

## [121] "mlpWeightDecayML" "monmlp" "msaenet" "multinom" "mxnet"

## [126] "mxnetAdam" "naive_bayes" "nb" "nbDiscrete" "nbSearch"

## [131] "neuralnet" "nnet" "nnls" "nodeHarvest" "null"

## [136] "OneR" "ordinalNet" "ordinalRF" "ORFlog" "ORFpls"

## [141] "ORFridge" "ORFsvm" "ownn" "pam" "parRF"

## [146] "PART" "partDSA" "pcaNNet" "pcr" "pda"

## [151] "pda2" "penalized" "PenalizedLDA" "plr" "pls"

## [156] "plsRglm" "polr" "ppr" "PRIM" "protoclass"

## [161] "qda" "QdaCov" "qrf" "qrnn" "randomGLM"

## [166] "ranger" "rbf" "rbfDDA" "Rborist" "rda"

## [171] "regLogistic" "relaxo" "rf" "rFerns" "RFlda"

## [176] "rfRules" "ridge" "rlda" "rlm" "rmda"

## [181] "rocc" "rotationForest" "rotationForestCp" "rpart" "rpart1SE"

## [186] "rpart2" "rpartCost" "rpartScore" "rqlasso" "rqnc"

## [191] "RRF" "RRFglobal" "rrlda" "RSimca" "rvmLinear"

## [196] "rvmPoly" "rvmRadial" "SBC" "sda" "sdwd"

## [201] "simpls" "SLAVE" "slda" "smda" "snn"

## [206] "sparseLDA" "spikeslab" "spls" "stepLDA" "stepQDA"

## [211] "superpc" "svmBoundrangeString" "svmExpoString" "svmLinear" "svmLinear2"

## [216] "svmLinear3" "svmLinearWeights" "svmLinearWeights2" "svmPoly" "svmRadial"

## [221] "svmRadialCost" "svmRadialSigma" "svmRadialWeights" "svmSpectrumString" "tan"

## [226] "tanSearch" "treebag" "vbmpRadial" "vglmAdjCat" "vglmContRatio"

## [231] "vglmCumulative" "widekernelpls" "WM" "wsrf" "xgbDART"

## [236] "xgbLinear" "xgbTree" "xyf"

Para o nosso exemplo vamos utilizar o “glm” (generalized linear model).

Agora vamos criar o nosso modelo, utilizando apenas a amostra treino. Para isso vamos usar o comando train().

modelo = train(type ~ ., data = treino, method = "glm")

No primeiro argumento colocamos qual variável estamos tentando prever em função de qual(is). No nosso caso, queremos prever “type” em função (“~”) de todas as outras, por isso utilizamos o “.”. Em seguida dizemos de qual base de dados queremos construir o modelo e por último o método de treinamento utilizado.

Agora vamos dar uma olhada no nosso modelo.

modelo

## Generalized Linear Model

##

## 3451 samples

## 57 predictor

## 2 classes: 'nonspam', 'spam'

##

## No pre-processing

## Resampling: Bootstrapped (25 reps)

## Summary of sample sizes: 3451, 3451, 3451, 3451, 3451, 3451, ...

## Resampling results:

##

## Accuracy Kappa

## 0.9224544 0.8365594

Podemos observar que utilizamos uma amostra de tamanho 3451 no treino e 57 preditores para prever a qual classe um e-mail pertence, spam ou não spam. O que a função faz é realizar várias maneiras diferentes de testar se esse modelo funcionará bem e usar isso para selecionar o melhor modelo. Neste caso ela usou a reamostragem por bootstrapping com 25 replicações (o default da função).

Uma vez que ajustamos o modelo podemos aplicá-lo na amostra teste, para estimarmos a precisão do classificador. Para isso utilizamos o comando predict(). Dentro da função nós passamos o modelo que ajustamos no treino e em qual base de dados gostaríamos de realizar a predição.

predicao = predict(modelo, newdata = teste)

head(predicao, n=30)

## [1] spam spam spam spam spam spam spam nonspam nonspam spam spam spam nonspam nonspam

## [15] spam spam spam spam spam spam spam spam spam spam spam spam spam spam

## [29] spam spam

## Levels: nonspam spam

Ao fazermos isso obtemos uma série de predições para as classes dos e-mails do conjunto teste. Podemos então realizar a avaliação do modelo comparando os resultados da predição com as reais classes dos e-mails, por meio do comando confusionMatrix().

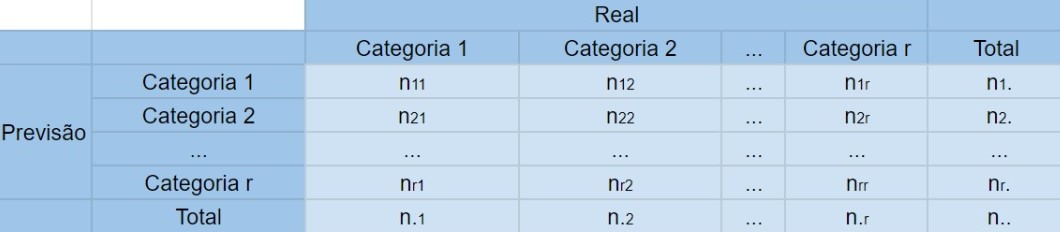

Matriz de Confusão (Confusion Matrix)

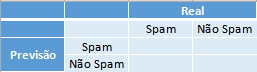

A matriz de confusão é a matriz de comparação feita após a predição, onde as linhas correspondem ao que foi previsto e as colunas correspondem à verdade conhecida.

Exemplo: A matriz de confusão para o problema de predição dos e-mails em spam ou não spam fica da seguinta forma:

Onde na primeira coluna se encontram os elementos que possuem a característica de interesse (os e-mails que são spam), e, respectivamente nas linhas, os que foram corretamente identificados - o qual são chamados de Verdadeiros Positivos (VP) - e os que foram erroneamente identificados - os Falsos Negativos (FP). Na segunda coluna se encontram os elementos que não possuem a característica de interesse (os e-mails que são ham) e, respectivamente nas linhas, os que foram erroneamente identificados - o qual são chamados de Falsos Positivos (FN) - e os que foram corretamente identificados - os Verdadeiros Negativos (VN).

Com as devidas classificações a matriz de confusão fica da seguinte forma:

Dentro da função passamos as predições que obtemos pelo modelo ajustado e as reais classificações dos e-mails do conjunto teste.

confusionMatrix(predicao, teste$type)

## Confusion Matrix and Statistics

##

## Reference

## Prediction nonspam spam

## nonspam 659 55

## spam 38 398

##

## Accuracy : 0.9191

## 95% CI : (0.9018, 0.9342)

## No Information Rate : 0.6061

## P-Value [Acc > NIR] : < 0.0000000000000002

##

## Kappa : 0.8295

##

## Mcnemar's Test P-Value : 0.09709

##

## Sensitivity : 0.9455

## Specificity : 0.8786

## Pos Pred Value : 0.9230

## Neg Pred Value : 0.9128

## Prevalence : 0.6061

## Detection Rate : 0.5730

## Detection Prevalence : 0.6209

## Balanced Accuracy : 0.9120

##

## 'Positive' Class : nonspam

##

A função retorna a matriz de confusão e alguns dados estatísticos, como por exemplo a Precisão (Accuracy), o Intervalo de Confiança com 95% de confiança (95% CI), a Sensibilidade (Sensitivity), Especificidade (Specificity), entre outros.

Podemos notar que o GLM foi um bom modelo de treinamento para os nossos dados pois obtivemos altas taxas de acertos: uma precisão de 0,94, 0,96 de sensitividade e 0,90 de especificidade. Vamos ver melhor algumas dessas estatísticas:

Definição (Sensibilidade): A sensibilidade de um método de predição é a porcentagem dos elementos da amostra que possuem a característica de interesse e foram corretamente identificados. Para o nosso exemplo dos e-mails, a sensabilidade é a porcentagem dos e-mails que são spam e foram classificados pelo nosso algoritmo de predição como spam.

Ou seja, podemos escrever \(Sensibilidade = \frac{VP}{VP+FN}\)

Definição (Especificidade): A especificidade de um método de predição é a porcentagem dos elementos da amostra que não possuem a característica de interesse e foram corretamente identificados. Para o nosso exemplo dos e-mails, a especificidade é a porcentagem dos e-mails que são “ham” e o algoritmo de predição os classificou como tal.

Ou seja, podemos escrever \(Especificidade=\frac{VN}{VN+FP}\)

Quando obtemos as sensibilidades e as especificidades de diferentes preditores, naturalmente surge o questionamente: qual deles é melhor para estimar as verdadeiras características de interesse? A resposta depende do que é mais importante para o problema.

Se identificar corretamente os positivos for mais importante, utilizamos o preditor com maior sensibilidade. Se identificar corretamente os negativos for mais importante, utilizamos o preditor com maior especificidade.

Outra medida para avaliar a qualidade do nosso preditor é a precisão (Accuracy). Ela avalia a porcentagem de acertos que tivemos em geral. Ou seja, somamos o número de Verdadeiros Positivos com o número de Verdadeiros Negativos e dividimos pelo tamanho da amostra. \(Precisão=\frac{VP+VN}{VP+VN+FN+FP}\)

Para demais medidas da matriz de confusão consulte o [apêndice].

Avaliando Regressores

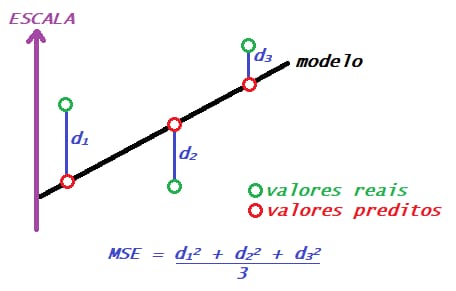

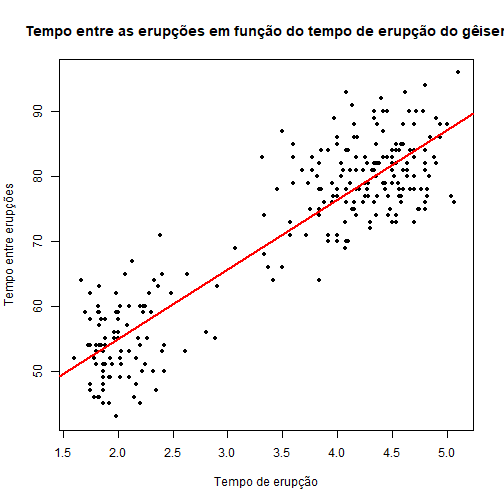

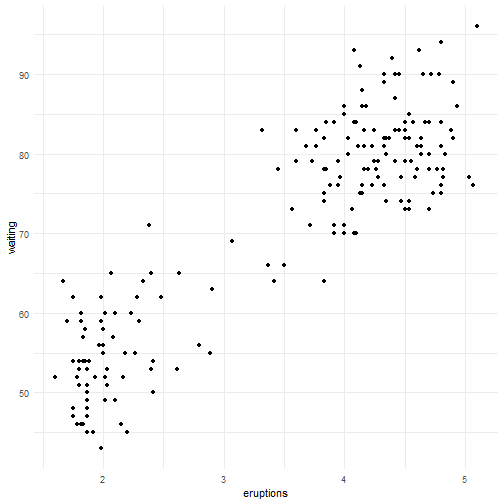

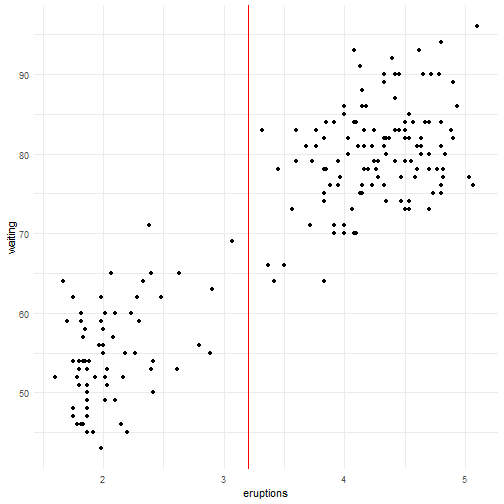

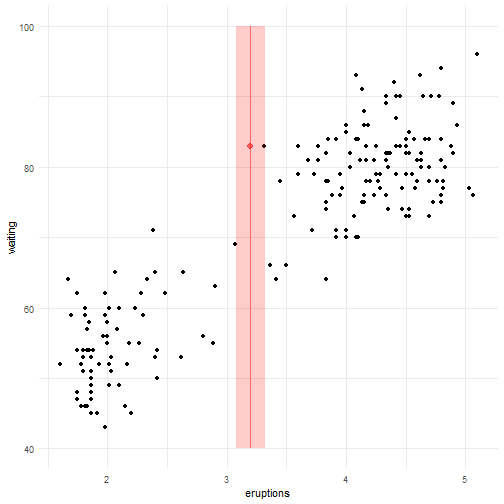

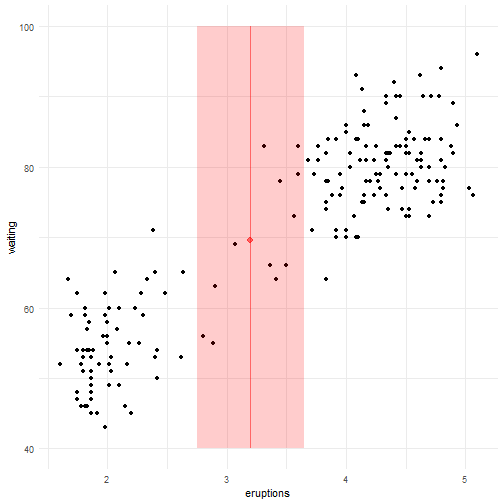

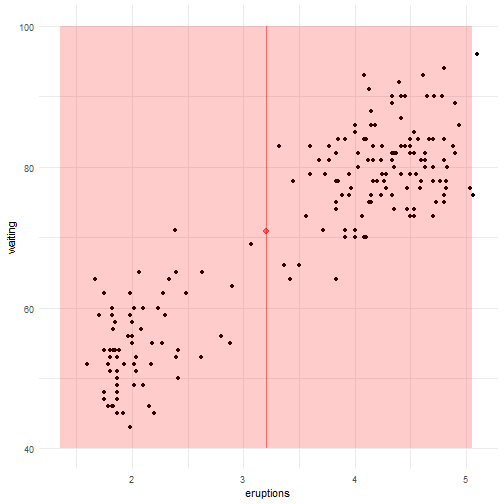

Agora vamos utilizar a base de dados faithful para tentar prever o tempo de espera (waiting) entre uma erupção e outra de um gêiser dado a duração das erupções (eruption).

data("faithful")

head(faithful)

## eruptions waiting

## 1 3.600 79

## 2 1.800 54

## 3 3.333 74

## 4 2.283 62

## 5 4.533 85

## 6 2.883 55

Primeiro, vamos separar a amostra em treino e teste.

set.seed(39)

noTreino = createDataPartition(y=faithful$waiting, p=0.7, groups = 5, list=F)

treino = faithful[noTreino,]; teste = faithful[-noTreino,]

Quando o argumento y é numérico, a amostra é dividida em grupos com base nos percentis e é feita uma amostragem estratificada. O número de percentis é definido pelo argumento groups.

Agora temos que treinar nosso modelo. Para esse exemplo vamos usar a Regressão Linear (LM - Linear Regression).

Os métodos disponíveis e seus usos podem ser encontrados no guia do caret.

Vamos treinar nosso modelo utilizando a amostra treino.

modelo = caret::train(waiting~eruptions, data = treino, method = "lm")

Novamente, colocamos a variável que tentamos prever em função das outras. No caso, só temos duas variáveis então não precisamos colocar o ponto como no [classificador].

modelo

## Linear Regression

##

## 192 samples

## 1 predictor

##

## No pre-processing

## Resampling: Bootstrapped (25 reps)

## Summary of sample sizes: 192, 192, 192, 192, 192, 192, ...

## Resampling results:

##

## RMSE Rsquared MAE

## 6.060639 0.805468 4.948071

##

## Tuning parameter 'intercept' was held constant at a value of TRUE

Podemos ver que temos 192 observações no conjunto treino e 1 preditor.

Agora vamos aplicar nosso modelo na amostra teste para avaliar o erro dele.

predicao = predict(modelo, newdata = teste)

Assim como no classificador, a função predict nos retorna a previsão dos tempos entre as erupções dado os tempos das durações das erupções.

MSE

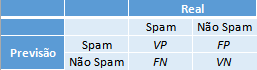

Assim como há diversas formas de compararmos a qualidade dos classificadores, há também diversas formas de compararmos regressores. O que estudaremos agora é o MSE (mean squared error - erro quadrático médio). Mais formas de comparação de regressores também serão vistas futuramente.

O MSE é a média de quanto os valores previstos para as observações se distanciaram dos valores verdadeiros dessa observação. Obtemos ele somando essas distâncias entre os valores previstos e os reais ao quadrado e dividindo por n.

\[MSE=\frac{1}{n} \sum\limits_{i=1}^{n} \left( Yreal_i-Yestimado_i \right)^{2}\]

Ex.: O erro quadrático médio para o problema de tempo de erupção do gêiser.

data("faithful")

head(faithful)

## eruptions waiting

## 1 3.600 79

## 2 1.800 54

## 3 3.333 74

## 4 2.283 62

## 5 4.533 85

## 6 2.883 55

# Gráfico do tempo entre as erupções em função do tempo de erupção do gêiseres

plot(faithful$eruptions, faithful$waiting, pch = 20, ylab="Tempo entre Erupções",

xlab = "Tempo de Erupção", main = "Tempo entre as erupções em função do tempo de erupção do gêiser")

Podemos notar que há uma relação linear positiva entre as variáveis. Vamos então ajustar um modelo de regressão linear.

modelo = lm(faithful$waiting~faithful$eruptions)

plot(y = faithful$waiting, x = faithful$eruptions, pch = 20, ylab="Tempo entre erupções",

xlab = "Tempo de erupção", main = "Tempo entre as erupções em função do tempo de erupção do gêiser")

abline(modelo, col = "red", lwd = 2)

Na reta de regressão temos todos os valores previstos para o tempo de erupção de acordo com os tempos de espera. Podemos então calcular o MSE para o nosso modelo utilizando o comando mse().

mse = sum((teste$waiting-predicao)**2)/nrow(teste)

mse

## [1] 32.41941

Então temos que, em média, o valor estimado para a variável de interesse no conjunto de teste se distancia do valor real observado em 32,41941 escores. Note que esta é uma medida que soma as distâncias ao quadrado, por isso o MSE é um número relativamente grande.

Cross Validation (Validação Cruzada)

Existem diversos métodos de aprendizado de máquina que podemos usar para construir um preditor. Então como saber qual método é melhor? Um jeito de fazer isso é usando a validação cruzada.

A Validação Cruzada nos permite comparar diferentes métodos de aprendizado de máquina ou parâmetros para o método escolhido e avaliar qual funcionará melhor na prática.

Então o que vamos fazer é, para cada método,

- Separar os dados em conjunto de treino e conjunto de teste.

- Treinar um modelo no conjunto de treino.

- Avaliar no conjunto de teste

- Repetir os passos 1-3 e estimar o erro.

Bem, já sabemos que não é uma boa ideia usar toda a base de dados para treinar o nosso preditor e então podemos dividir por exemplo os primeiros 75% dos dados para treino e 25% finais para teste. Mas, e se esse não for o melhor jeito de dividir nossos dados? E se o melhor jeito de fazer essa divisão for usando os primeiros 25% para teste e o restante para treino? A Validação cruzada leva em consideração todas essas divisões usando uma de cada vez e tirando a média dos resultados no final. Para isso veremos como realizar alguns métodos de reamostragem, para utilizarmos várias amostras possíveis e não ficarmos dependentes de uma única amostra.

Alguns Métodos de Reamostragem

Agora vamos compreender como fatiar os dados para realizarmos a reamostragem. Existem vários métodos possíveis mas vamos nos focar em três: k-fold, repeated k-fold e bootstrap.

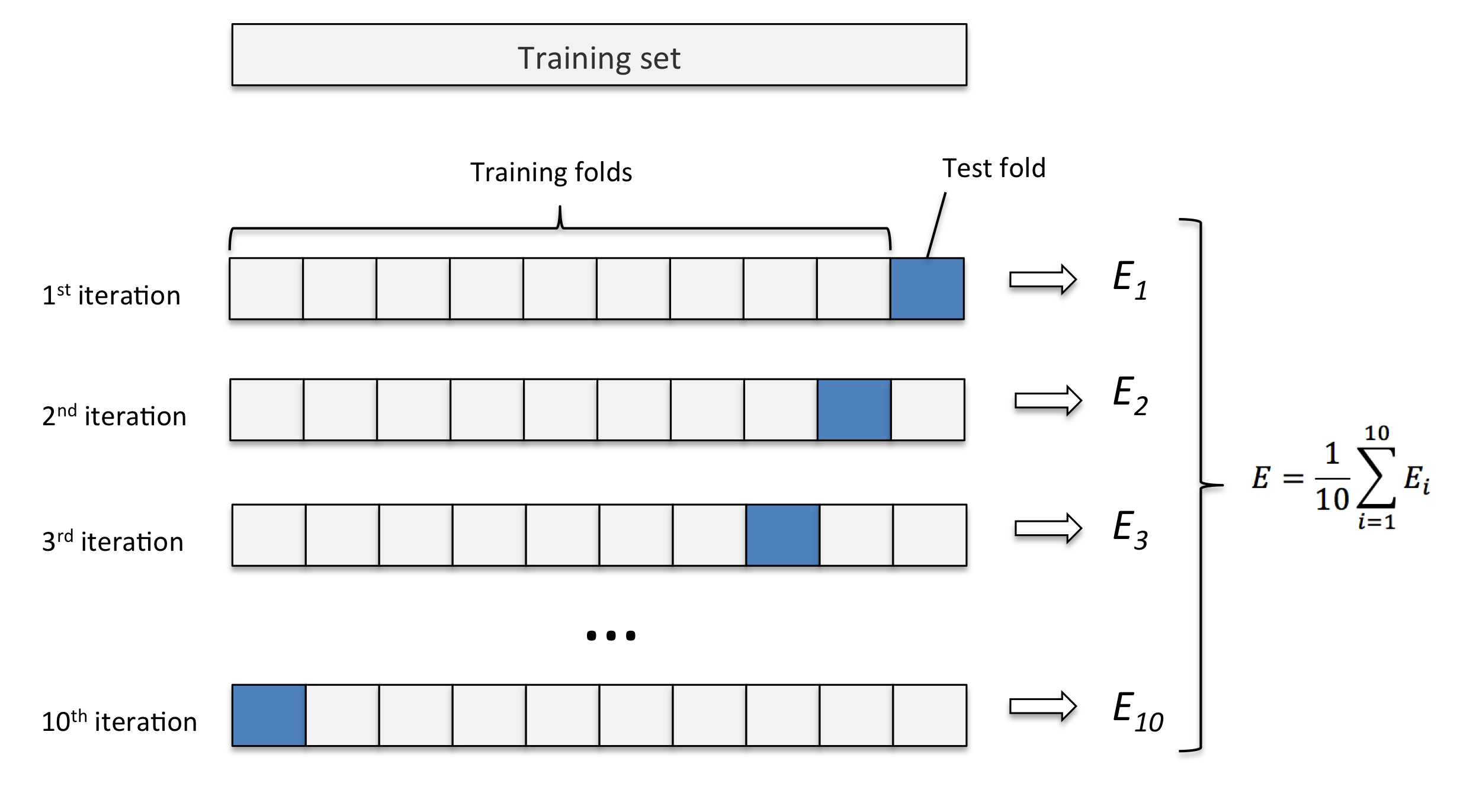

K-fold

Este método consiste em fatiar os dados em k pedaços iguais. Utilizamos um pedaço para o teste e os demais para o treino. Então realizamos esse procedimento k vezes, de modo que em cada repetição um novo pedaço seja utilizado para o teste. Para avaliar o erro nós tiramos a média de todos os erros de todas as replicações.

Exemplo: K-fold com 10 partes:

Quanto maior o k escolhido obtemos menos viés, porém mais variância. Em outras palavras, você terá uma estimativa muito precisa do viés entre os valores previstos e os valores verdadeiros, porém altamente variável. Agora quanto menor o k escolhido, mais viés e menos variância. Ou seja, não iremos necessariamente obter uma boa estimativa do viés, mas ela será menos variável.

OBS: Quando o k é igual ao tamanho da amostra, o método é também conhecido como leave-one-out.

Ex.: vamos utilizar reamostragem por k-fold no conjunto de dados spam.

library(caret)

library(kernlab)

data(spam)

noTreino = createDataPartition(y = spam$type, p = 0.75, list = F)

treino = spam[noTreino,]

teste = spam[-noTreino,]

# Para fazer a reamostragem por k-fold vamos utilizar o comando createFolds():

folds = createFolds(y = spam$type, k = 10, list = T, returnTrain = T)

Os principais argumentos da função createFolds() são:

- y = a variável de interesse (no nosso caso, o tipo do e-mail);

- k = o número (inteiro) de partições que você deseja.

- list = argumento do tipo logical. Se TRUE $\rightarrow$ os resultados serão mostrados em uma lista, se FALSE $\rightarrow$ os resultados serão mostrados em uma matriz.

- returnTrain = argumento do tipo logical. Se TRUE, retorna amostras treino. Se FALSE, retorna amostras teste.

Vamos verificar o tamanho de cada partição da nossa amostra treino:

sapply(folds,length)

## Fold01 Fold02 Fold03 Fold04 Fold05 Fold06 Fold07 Fold08 Fold09 Fold10

## 4141 4141 4141 4141 4140 4141 4141 4141 4141 4141

Agora vamos fazer o mesmo para a amostra teste:

folds = createFolds(y = spam$type, k = 10, list = T, returnTrain = F)

sapply(folds,length)

## Fold01 Fold02 Fold03 Fold04 Fold05 Fold06 Fold07 Fold08 Fold09 Fold10

## 459 460 460 460 460 461 460 461 460 460

Outra opção de realizar a reamostragem por k-fold é aplicá-la diretamente na função train.

controle = trainControl(method = "cv", number = 10)

modelo = caret::train(type ~ ., data = spam, method = "glm", trControl = controle)

Repeated K-fold

O repeated k-fold se resume a repetir o método k-fold várias vezes, com o objetivo de melhorar nossa reamostragem.

Ex.: Vamos aplicar um método de treino 3 vezes em 10 folds.

controle = trainControl(method = "repeatedcv", number = 10, repeats = 3)

modelo = caret::train(type ~ ., data = spam, method = "glm", trControl = controle)

Bootstrap

O bootstrap é uma técnica de reamostragem com o propósito de reduzir desvios e realizar amostragem dos dados de treino com repetições. Já vimos anteriormente que este é o método default do comando train(), onde é feito 25 reamostragens por bootstrap.

Embora esse seja o padrão podemos alterar através do comando trainControl(). Por exemplo, vamos alterar o número de reamostragens de 25 para 10.

controle = trainControl(method = "boot", number = 10)

modelo = train(type ~ ., data = spam, method = "glm", trControl = controle)

Podemos também realizarmos bootstrap fora da função train(), utilizando o comando createResample().

folds = createResample(y = spam$type, times = 10, list = F)

Comparando Funções Preditoras

Como já foi dito em capítulos anteriores, existem diversas formas de comparar preditores. Nesse capítulo, vamos estudar um meio de fazer isso e ver mais detalhadamente as medidas de comparação que o R retorna ao usarmos esse método.

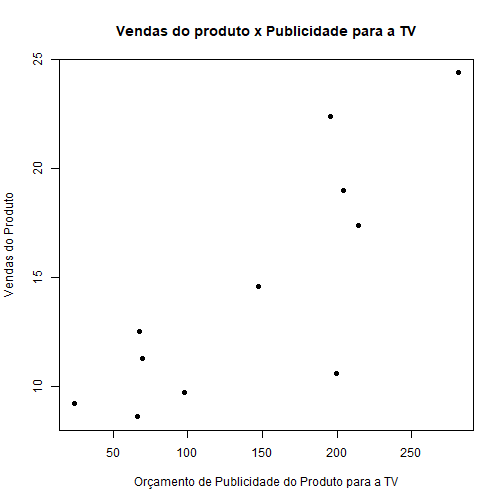

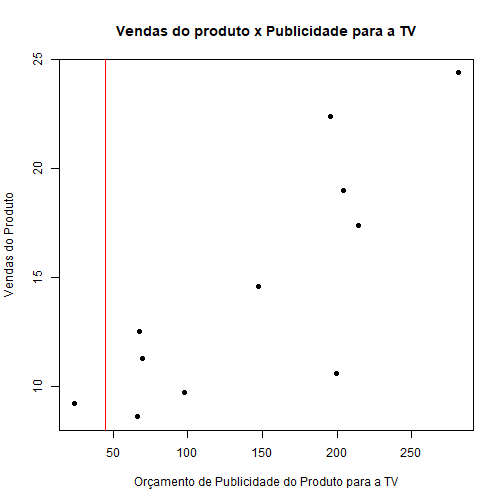

Exemplo de Comparação de Regressores - base faithful

Vamos usar a base de dados faithful já presente no R.

data("faithful")

# verificando a estrutura da base

str(faithful)

## 'data.frame': 272 obs. of 2 variables:

## $ eruptions: num 3.6 1.8 3.33 2.28 4.53 ...

## $ waiting : num 79 54 74 62 85 55 88 85 51 85 ...

Note que a base apresenta apenas duas variáveis: eruptions, que contém uma amostra corresponde ao tempo em minutos que o gêiser Old Faithful permanece em erupção e waiting, que contém uma amostra correspondente ao tempo em minutos até a próxima erupção. Vamos tentar prever a variável waiting através da variável eruptions. Note ainda que a variável de interesse é quantitativa contínua, portanto queremos construir um regressor.

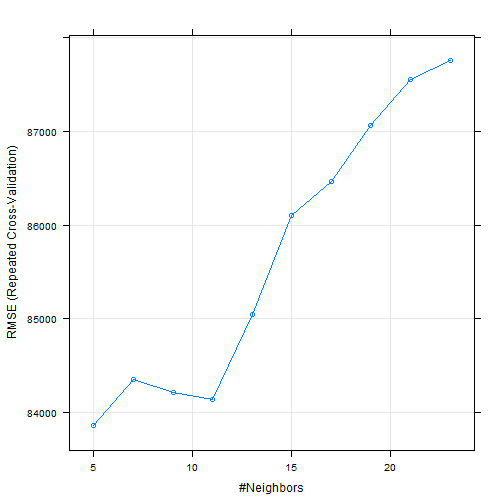

Vamos treinar nosso modelo utilizando 3 métodos separadamente: linear model, Projection Pursuit Regression e k-Nearest Neighbor. Para fazer a comparação, vamos colocar a mesma semente antes de cada treino para que todos sejam feitos da mesma forma e assim torne a comparação mais “justa”. Note também que estamos usando toda a base de dados pra treinar o medelo. Isso porque estamos apenas avaliando o melhor modelo.

library(caret)

# usando o método de validação cruzada tiramos a dependência da amostra

TC = trainControl(method="repeatedcv", number=10,repeats=3)

set.seed(371)

modelo_lm = train(waiting~eruptions, data=faithful, method="lm", trControl=TC)

set.seed(371)

modelo_ppr = train(waiting~eruptions, data=faithful, method="ppr", trControl=TC)

set.seed(371)

modelo_knn = train(waiting~eruptions, data=faithful, method="knn", trControl=TC)

Agora, como sabemos qual desses é o melhor modelo para nosso Regressor?

resultados = resamples(list(LM=modelo_lm, PPR=modelo_ppr, KNN=modelo_knn))

summary(resultados)

##

## Call:

## summary.resamples(object = resultados)

##

## Models: LM, PPR, KNN

## Number of resamples: 30

##

## MAE

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 3.816660 4.396526 4.723050 4.792316 5.063279 6.087023 0

## PPR 3.847465 4.329571 4.638090 4.728487 5.133559 5.980745 0

## KNN 3.565922 4.380002 4.717796 4.735160 5.167973 5.909983 0

##

## RMSE

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 4.769227 5.375918 5.919905 5.877351 6.204474 7.037539 0

## PPR 4.775950 5.258969 5.871960 5.725215 6.099465 6.865713 0

## KNN 4.564997 5.308376 5.828188 5.773268 6.275956 6.892789 0

##

## Rsquared

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 0.7232859 0.7855436 0.8198045 0.8154236 0.8443912 0.8715797 0

## PPR 0.7461656 0.7964453 0.8243005 0.8241913 0.8567375 0.8812427 0

## KNN 0.7636897 0.7964592 0.8227743 0.8218778 0.8453996 0.8771367 0

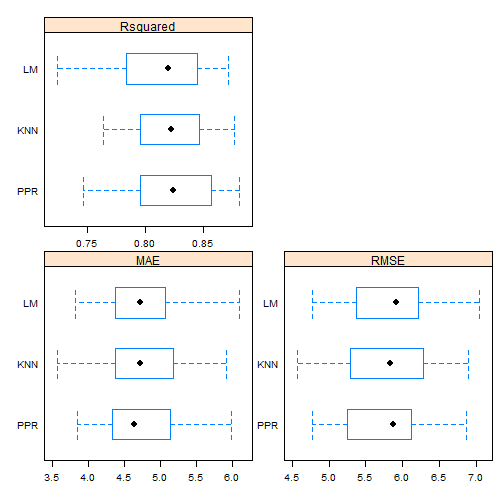

Repare que foi calculada três diferentes medidas: “MAE”, “RMSE”, e “Rsquared”.

O Erro Médio Absoluto (MAE - Mean Absolute Error) é dado pelo média dos desvios absolutos. \(MAE = \frac{\sum\limits_{i=1}^{n}\mid estimado_i - real_i\mid}{n}\quad, i=1,2,...,n.\)

A Raiz do Erro Quadrático Médio (RMSE - Root Mean Squared Error), como o nome já diz, não é nada mais que a raiz quadrada do Erro Quadrático Médio já citado no capítulo de [Tipos de Erro]. \(RMSE=\sqrt{MSE}=\sqrt{\frac{\sum\limits_{i=1}^{n} \left( estimado_i-real_i \right)^{2}}{n}}\quad, i=1,2,...,n.\)

O Coeficiente de Determinação, Também chamado de $R^2$ (R squared), é dado pela razão entre o MSE e a Variância subtraído de 1. \(R^2 =1- \frac{MSE}{Var}= 1-\frac{\sum\limits_{i=1}^{n} (real_i - estimado_i)^2}{\sum\limits_{i=1}^{n} (real_i - média)^2}\quad, i=1,2,...,n.\)

Portanto, queremos o modelo que possua MAE e RMSE baixo e $R^2$ alto. Para vizualizar melhor, podemos construir um boxplot comparativo da seguinte forma:

# Ajustando as escalas dos gráficos:

escala <- list(x=list(relation="free"), y=list(relation="free"))

# Plotando os dados:

bwplot(resultados, scales=escala)

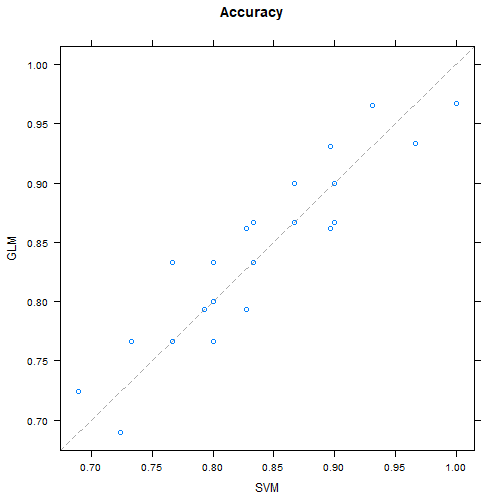

Pelos boxplots podemos perceber que o modelo linear é o que possui a pior mediana nas três medidas comparativas e parece ter os dados mais espalhados, principalmente no $R^2$, o que indica que ele possui alta variabilidade. Quanto ao KNN e o PPR, os dados estão mais concentrados no RMSE e no $R^2$, embora tenham bastante outliers. Parece que o PPR é levemente melhor que o KNN, mas é preciso uma análise mais profunda.

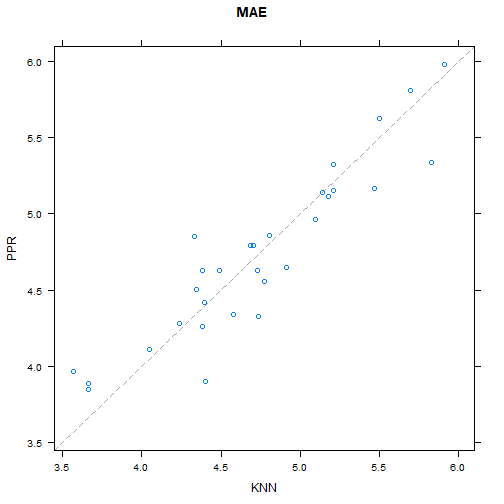

library(lattice)

# Comparando o comportamento de cada fold nos modelos KNN e PPR

xyplot(resultados, models=c("PPR", "KNN"))

Note que a maior parte dos folds está acima da diagonal, indicando que o KNN tem um erro absoluto médio (MAE) menor que o PPR. Vamos olhar novamente para o cálculo que fizemos mais acima.

resultados = resamples(list(LM=modelo_lm, PPR=modelo_ppr, KNN=modelo_knn))

summary(resultados)

##

## Call:

## summary.resamples(object = resultados)

##

## Models: LM, PPR, KNN

## Number of resamples: 30

##

## MAE

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 3.816660 4.396526 4.723050 4.792316 5.063279 6.087023 0

## PPR 3.847465 4.329571 4.638090 4.728487 5.133559 5.980745 0

## KNN 3.565922 4.380002 4.717796 4.735160 5.167973 5.909983 0

##

## RMSE

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 4.769227 5.375918 5.919905 5.877351 6.204474 7.037539 0

## PPR 4.775950 5.258969 5.871960 5.725215 6.099465 6.865713 0

## KNN 4.564997 5.308376 5.828188 5.773268 6.275956 6.892789 0

##

## Rsquared

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## LM 0.7232859 0.7855436 0.8198045 0.8154236 0.8443912 0.8715797 0

## PPR 0.7461656 0.7964453 0.8243005 0.8241913 0.8567375 0.8812427 0

## KNN 0.7636897 0.7964592 0.8227743 0.8218778 0.8453996 0.8771367 0

Podemos notar que o KNN tem uma posição melhor que o PPR em todas as medidas. Como saber se essa diferença é significativa? Vamos calcular as diferenças entre os dois modelos e avaliar atravé do p-valor.

#Calcular diferença entre modelos, e realizar

#testes de hipótese para as diferenças.

diferencas = diff(resultados)

summary(diferencas)

##

## Call:

## summary.diff.resamples(object = diferencas)

##

## p-value adjustment: bonferroni

## Upper diagonal: estimates of the difference

## Lower diagonal: p-value for H0: difference = 0

##

## MAE

## LM PPR KNN

## LM 0.063829 0.057156

## PPR 0.18 -0.006673

## KNN 1.00 1.00

##

## RMSE

## LM PPR KNN

## LM 0.15214 0.10408

## PPR 0.002181 -0.04805

## KNN 0.422993 0.946570

##

## Rsquared

## LM PPR KNN

## LM -0.008768 -0.006454

## PPR 0.01111 0.002313

## KNN 0.54786 1.00000

Observe que, para cada medida, acima da diagonal temos a diferença entre os modelos e abaixo da diagonal o p-valor do teste de comparação entre eles. Portanto, se considerarmos um nível de significância de 1%, é razoável dizer que os modelos PPR e KKN produzem resultados significativamente diferentes. Sendo assim, escolheriamos o método KNN para treinar nosso modelo.

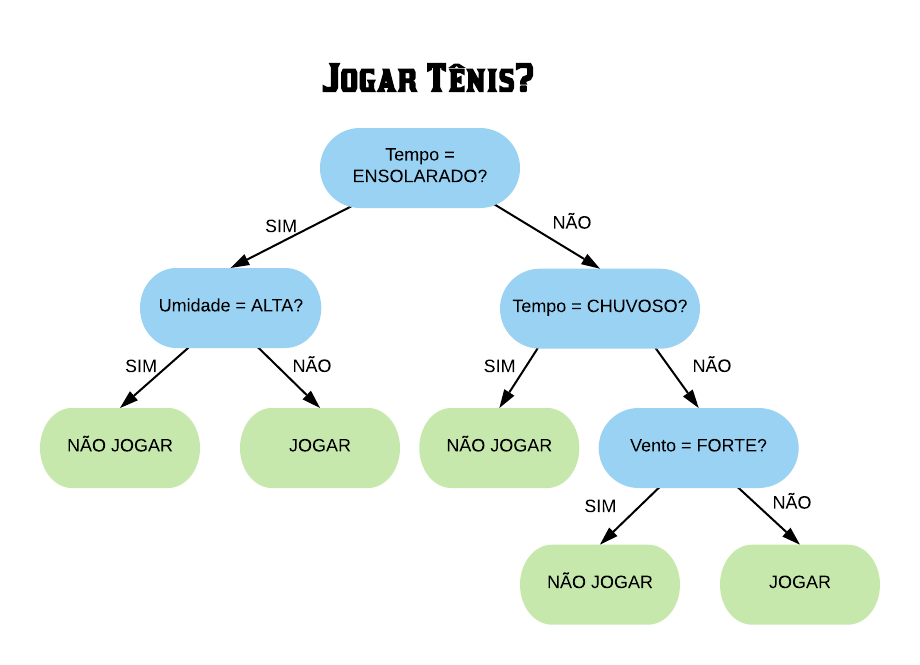

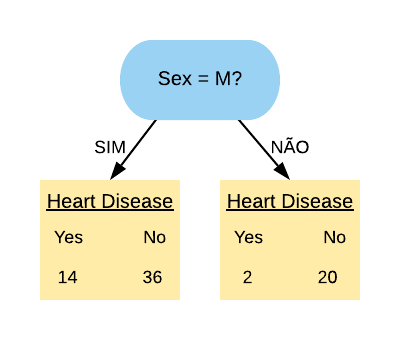

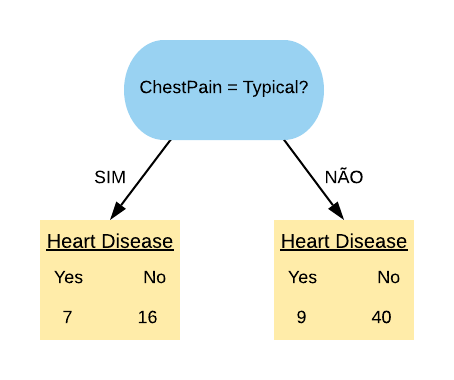

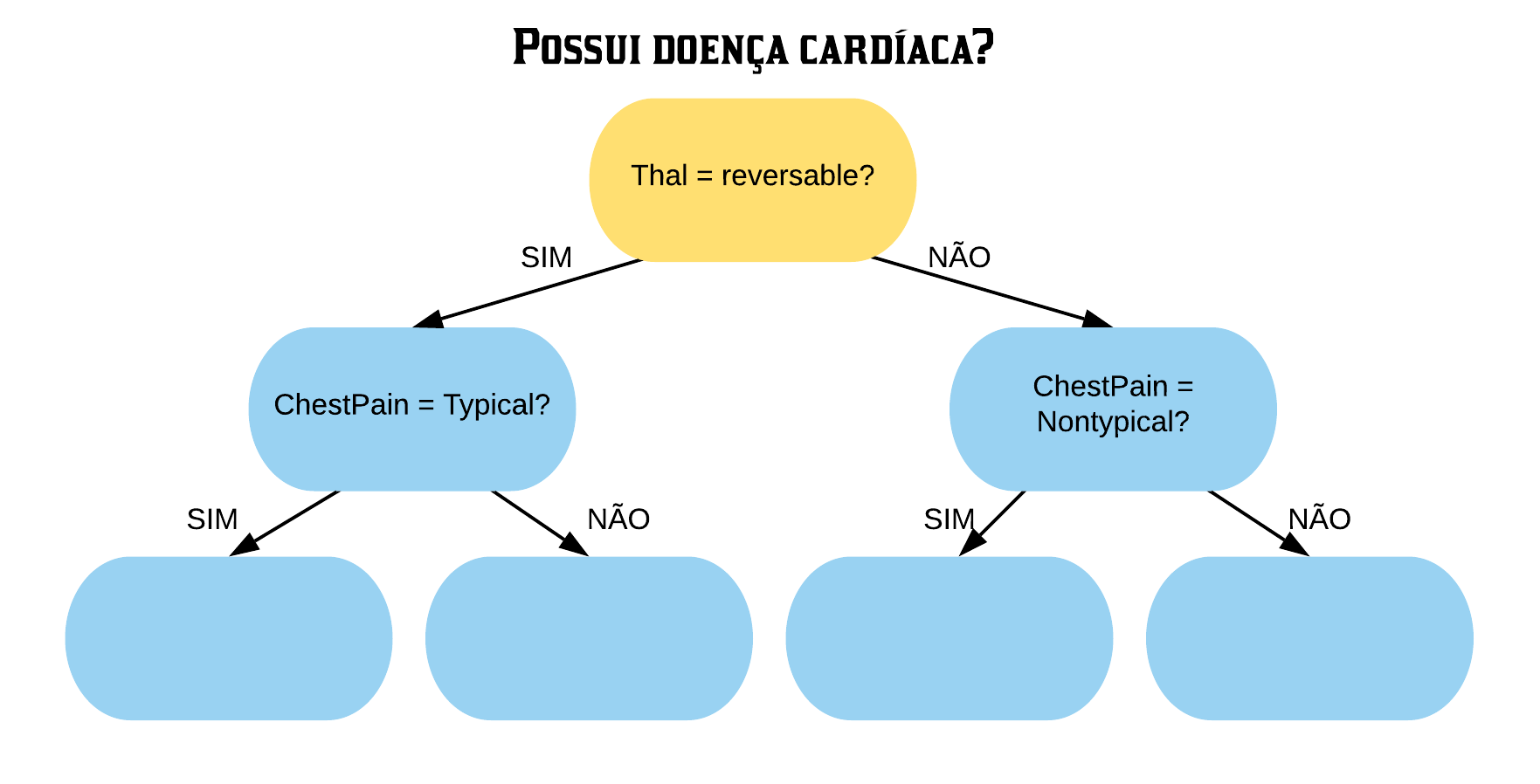

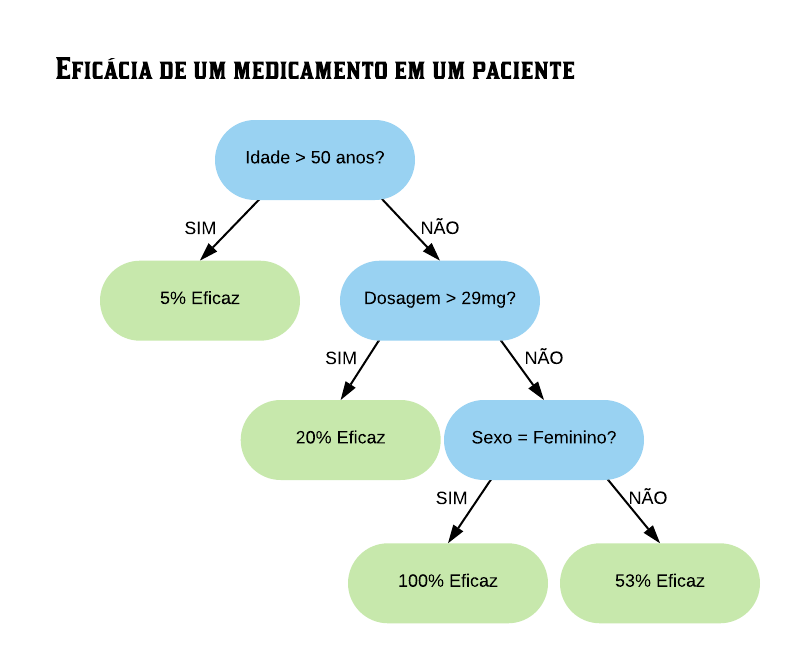

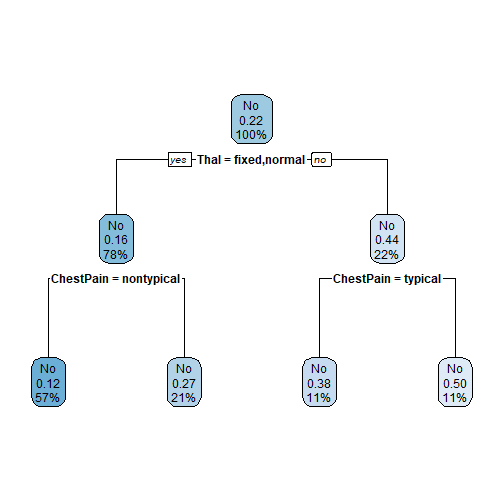

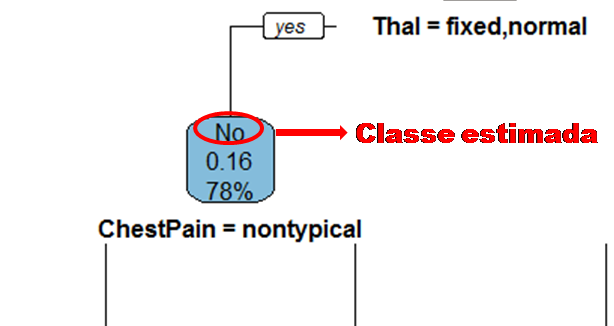

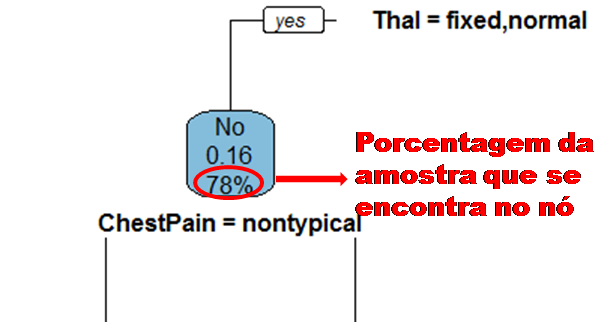

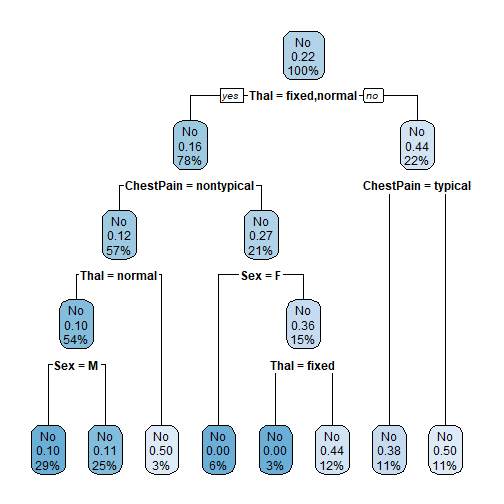

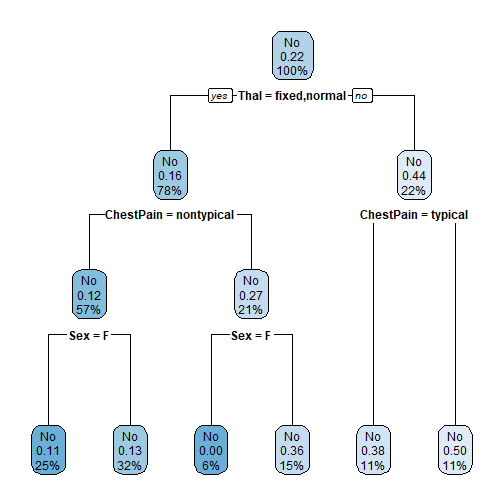

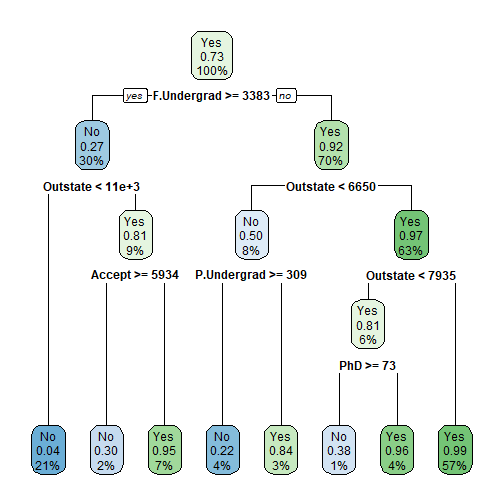

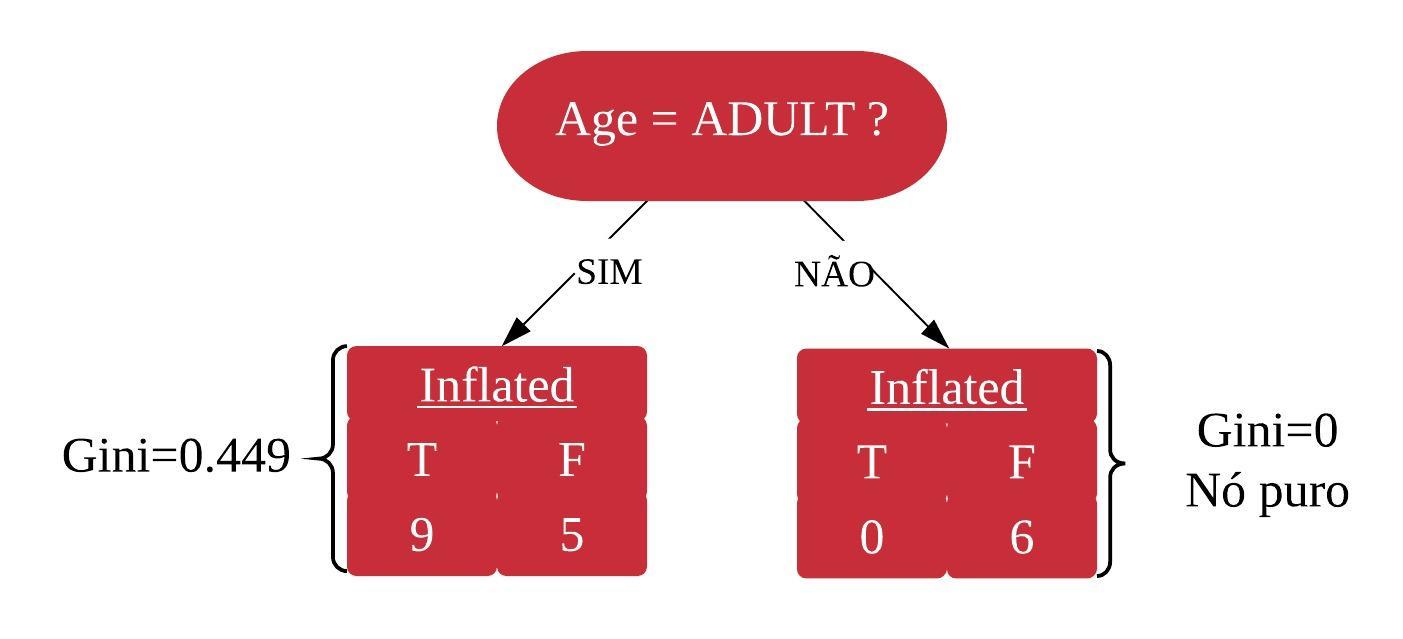

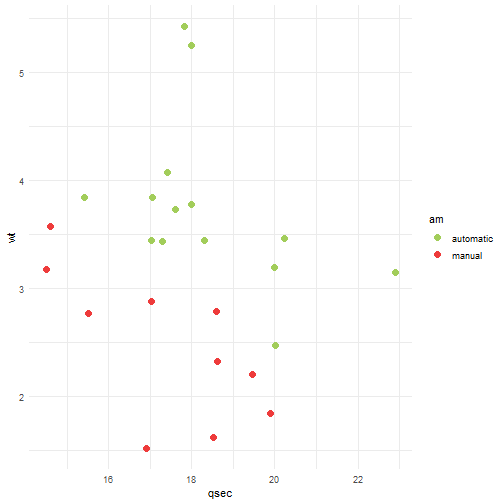

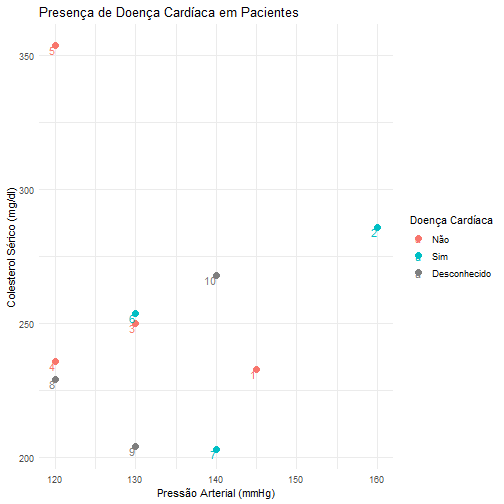

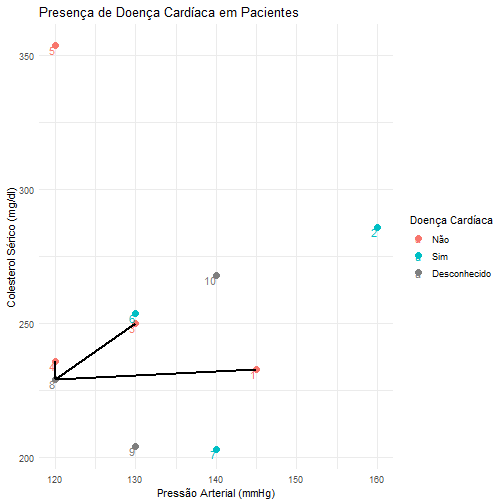

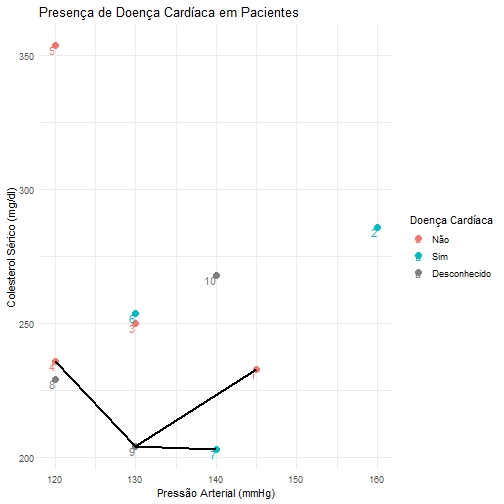

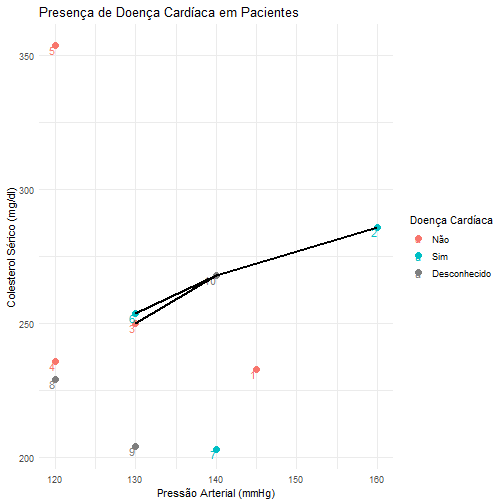

Exemplo de Comparação de Classificadores - base Heart

Suponha agora que queremos predizer se uma pessoa tem ou problema no coração dado que ela apresentou dor no peito. Considere a seguinte base de dados.

library(readr)

# lendo a base de dados

heart = read_csv("Heart.csv")

# verificando a estrutura da base

str(heart)

## tibble [297 x 15] (S3: spec_tbl_df/tbl_df/tbl/data.frame)

## $ X1 : num [1:297] 1 2 3 4 5 6 7 8 9 10 ...

## $ Age : num [1:297] 63 67 67 37 41 56 62 57 63 53 ...

## $ Sex : num [1:297] 1 1 1 1 0 1 0 0 1 1 ...

## $ ChestPain : chr [1:297] "typical" "asymptomatic" "asymptomatic" "nonanginal" ...

## $ RestBP : num [1:297] 145 160 120 130 130 120 140 120 130 140 ...

## $ Chol : num [1:297] 233 286 229 250 204 236 268 354 254 203 ...

## $ Fbs : num [1:297] 1 0 0 0 0 0 0 0 0 1 ...

## $ RestECG : num [1:297] 2 2 2 0 2 0 2 0 2 2 ...

## $ MaxHR : num [1:297] 150 108 129 187 172 178 160 163 147 155 ...

## $ ExAng : num [1:297] 0 1 1 0 0 0 0 1 0 1 ...

## $ Oldpeak : num [1:297] 2.3 1.5 2.6 3.5 1.4 0.8 3.6 0.6 1.4 3.1 ...

## $ Slope : num [1:297] 3 2 2 3 1 1 3 1 2 3 ...

## $ Ca : num [1:297] 0 3 2 0 0 0 2 0 1 0 ...

## $ Thal : chr [1:297] "fixed" "normal" "reversable" "normal" ...

## $ HeartDisease: chr [1:297] "No" "Yes" "Yes" "No" ...

## - attr(*, "spec")=

## .. cols(

## .. X1 = col_double(),

## .. Age = col_double(),

## .. Sex = col_double(),

## .. ChestPain = col_character(),

## .. RestBP = col_double(),

## .. Chol = col_double(),

## .. Fbs = col_double(),

## .. RestECG = col_double(),

## .. MaxHR = col_double(),

## .. ExAng = col_double(),

## .. Oldpeak = col_double(),

## .. Slope = col_double(),

## .. Ca = col_double(),

## .. Thal = col_character(),

## .. HeartDisease = col_character()

## .. )

Note que a variável de interesse HeartDisease é categórica, portanto estamos trabalhando com um Classificador.

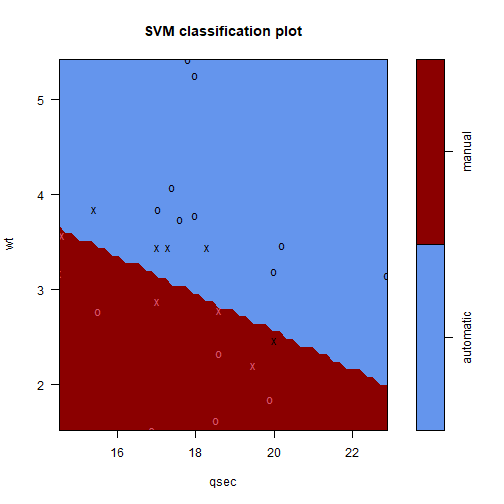

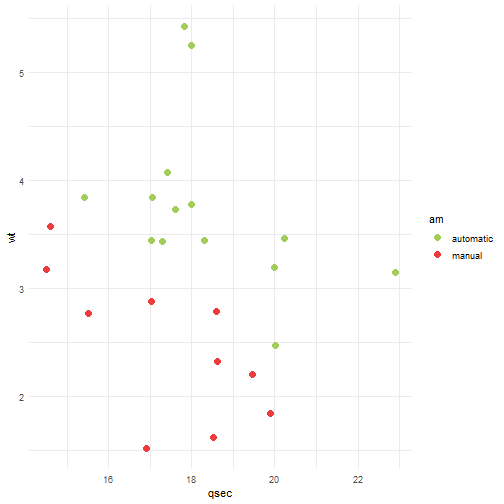

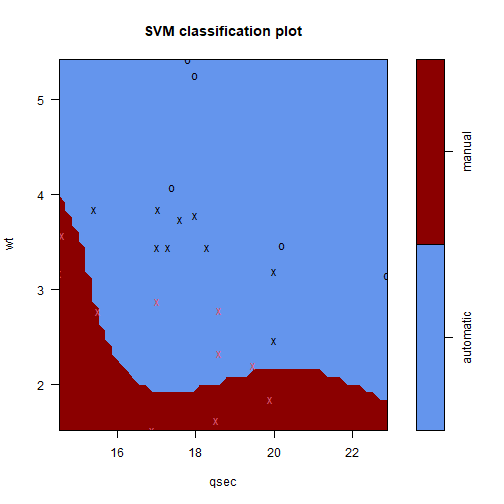

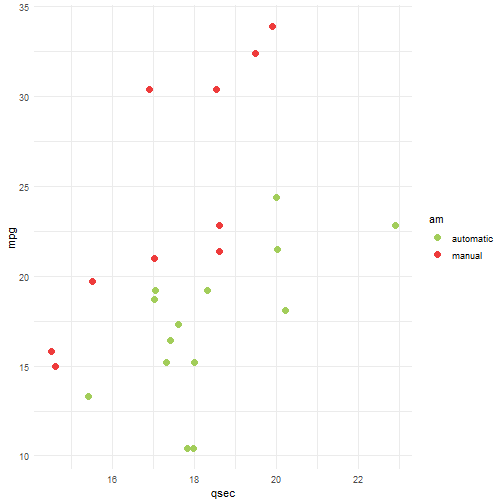

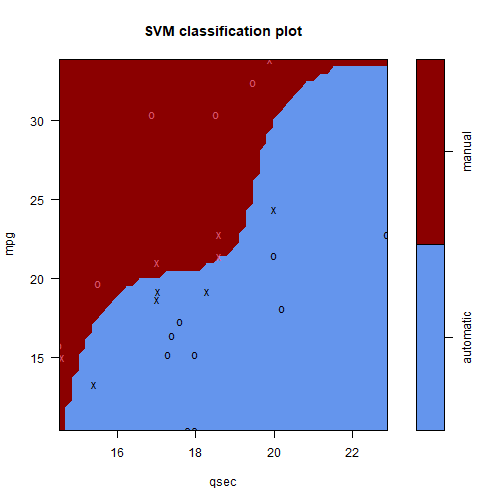

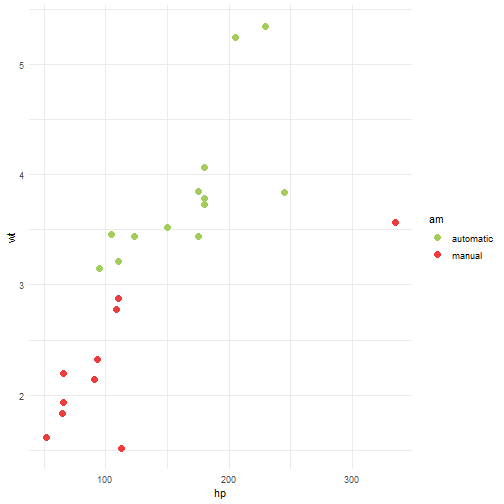

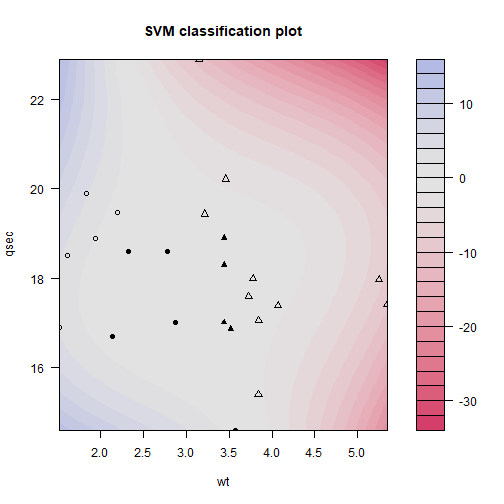

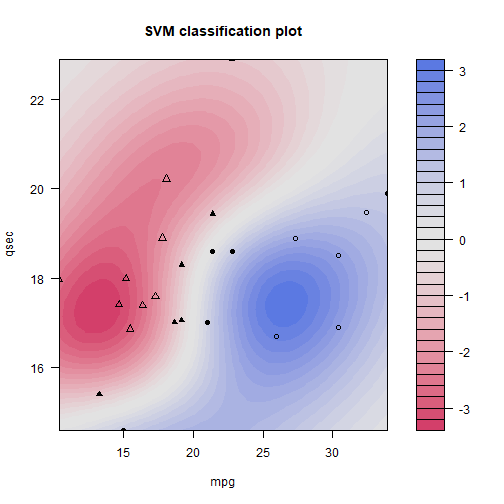

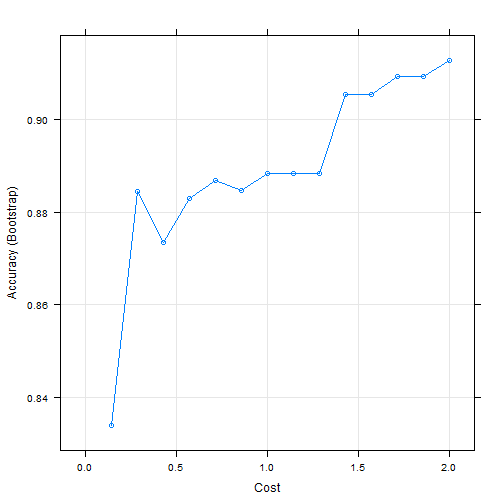

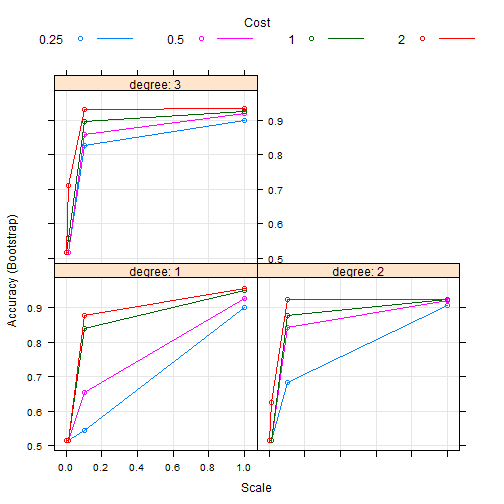

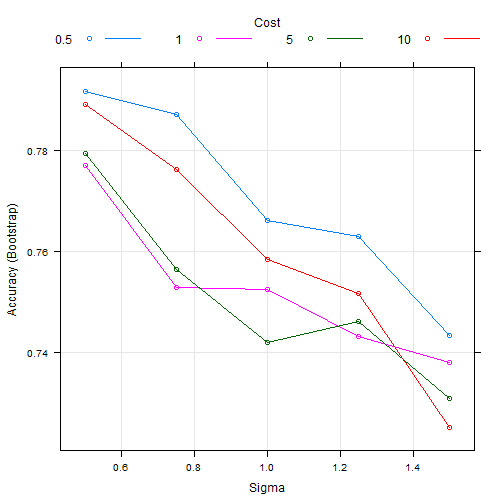

Vamos treinar nosso modelo utilizando 3 métodos separadamente: Recursive Partitioning and Regression Trees, Fitting Generalized Linear Models e Support Vector Machines. Novamente, vamos colocar a mesma semente antes de cada treino e utilizar toda a base de dados pra isso.

library(caret)

# usando o método de validação cruzada tiramos a dependência da amostra

TC = trainControl(method="repeatedcv", number=10,repeats=3)

set.seed(371)

modelo_rpart = caret::train(HeartDisease~., data=heart, method="rpart", trControl=TC)

set.seed(371)

modelo_glm = caret::train(HeartDisease~., data=heart, method="glm", trControl=TC)

set.seed(371)

modelo_svm = caret::train(HeartDisease~., data=heart, method="svmLinear", trControl=TC)

Assim como no caso anterior, vamos comparar os resultados obtidos por cada modelo.

resultados = resamples(list(Rpart=modelo_rpart, GLM=modelo_glm, SVM=modelo_svm))

summary(resultados)

##

## Call:

## summary.resamples(object = resultados)

##

## Models: Rpart, GLM, SVM

## Number of resamples: 30

##

## Accuracy

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## Rpart 0.5172414 0.7060345 0.7459770 0.7493103 0.8000000 0.8666667 0

## GLM 0.6896552 0.7948276 0.8477011 0.8438697 0.8916667 0.9666667 0

## SVM 0.6896552 0.8000000 0.8333333 0.8394253 0.8890805 1.0000000 0

##

## Kappa

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## Rpart 0.06451613 0.4105769 0.4971161 0.4956347 0.5973094 0.7368421 0

## GLM 0.34912718 0.5912008 0.6918699 0.6832658 0.7809134 0.9327354 0

## SVM 0.37708831 0.5912008 0.6651719 0.6740506 0.7727163 1.0000000 0

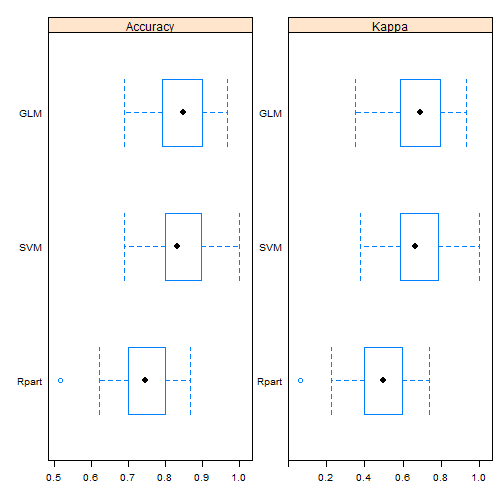

Repare que foi calculada duas diferentes medidas: “Accuracy”, e “Kappa”.

A Precisão (Accuracy) como já foi citado no capítulo [Introdução ao pacote caret], avalia a proporção de acertos na predição.\(Precisão=\frac{Predições\ corretas}{Total\ de\ predições}\)

O Coeficiente de concordância Kappa avalia o grau de concordância entre a classificação e o real valor de uma mesma amostra. E é calculado da seguinte forma:

Portanto, queremos que as duas medidas sejam altas. Vamos ver o boxplot.

# ajustando as escalas dos graficos

escala <- list(x=list(relation="free"), y=list(relation="free"))

# plotando os dados

bwplot(resultados, scales=escala)

Pelo boxplot podemos ver que o método Rpart possui uma alta variabilidade. O método GLM está com uma mediana melhor e parece mais concentrado. Mas será que ele é mesmo melhor que o SVM?

# Comparando o comportamento de cada fold nos modelos KNN e PPR

xyplot(resultados, models=c("GLM", "SVM"))

Por esse plot, não parece haver uma diferença significativa entre os dois métodos. Vamos voltar a nossas medidas.

resultados = resamples(list(Rpart=modelo_rpart, GLM=modelo_glm, SVM=modelo_svm))

summary(resultados)

##

## Call:

## summary.resamples(object = resultados)

##

## Models: Rpart, GLM, SVM

## Number of resamples: 30

##

## Accuracy

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## Rpart 0.5172414 0.7060345 0.7459770 0.7493103 0.8000000 0.8666667 0

## GLM 0.6896552 0.7948276 0.8477011 0.8438697 0.8916667 0.9666667 0

## SVM 0.6896552 0.8000000 0.8333333 0.8394253 0.8890805 1.0000000 0

##

## Kappa

## Min. 1st Qu. Median Mean 3rd Qu. Max. NA's

## Rpart 0.06451613 0.4105769 0.4971161 0.4956347 0.5973094 0.7368421 0

## GLM 0.34912718 0.5912008 0.6918699 0.6832658 0.7809134 0.9327354 0

## SVM 0.37708831 0.5912008 0.6651719 0.6740506 0.7727163 1.0000000 0

A precisão e kappa média também parecem próximas entre o GLM e o SVM. Vamos fazer então um teste de hipótese para confirmar.

#Calcular diferença entre modelos, e realizar

#testes de hipótese para as diferenças.

diferencas = diff(resultados)

summary(diferencas)

##

## Call:

## summary.diff.resamples(object = diferencas)

##

## p-value adjustment: bonferroni

## Upper diagonal: estimates of the difference

## Lower diagonal: p-value for H0: difference = 0

##

## Accuracy

## Rpart GLM SVM

## Rpart -0.094559 -0.090115

## GLM 0.000000002107 0.004444

## SVM 0.000000011839 1

##

## Kappa

## Rpart GLM SVM

## Rpart -0.187631 -0.178416

## GLM 0.00000000237 0.009215

## SVM 0.00000001173 1

Note que o p-valor da diferença é 1. Portanto, concluímos que não existe uma diferença significativa entre os métodos GLM e SVM para este caso.

Mas, e quanto ao tempo de processamento de cada modelo? Vamos usar a função Sys.time() para medir o tempo de treinamento nos dois métodos.

inicio1 <- Sys.time()

set.seed(371)

modelo_glm = train(HeartDisease~., data=heart, method="glm", trControl=TC)

fim1 <- Sys.time()

fim1 - inicio1

## Time difference of 1.028369 secs

inicio2 <- Sys.time()

set.seed(371)

modelo_svm = train(HeartDisease~., data=heart, method="svmLinear", trControl=TC)

fim2 <- Sys.time()

fim2 - inicio2

## Time difference of 1.108321 secs

Bem, não parece que a diferença foi muito grande. Mas, pense agora que você quer realizar uma comparação usando a validação cruzada com 20 folds e 100 repetições.

TC = trainControl(method="repeatedcv", number=20,repeats=100)

inicio1 <- Sys.time()

set.seed(371)

modelo_glm = train(HeartDisease~., data=heart, method="glm", trControl=TC)

fim1 <- Sys.time()

fim1 - inicio1

## Time difference of 27.45612 secs

inicio2 <- Sys.time()

set.seed(371)

modelo_svm = train(HeartDisease~., data=heart, method="svmLinear", trControl=TC)

fim2 <- Sys.time()

fim2 - inicio2

## Time difference of 34.9665 secs

A diferença de processamento agora já é um pouco maior. Mas, lembre que nossa base de dados contém apenas 297 observações e 15 variáveis. Numa base de dados muito grande e/ou em determinados métodos esse tempo fará diferença.

Pré-Processamento

Antes de criarmos um modelo de predição, é importante plotarmos as variáveis do nosso modelo antecipadamente para observarmos se há algum comportamento estranho entre elas. Por exemplo, podemos ter uma variável que assuma frequentemente um único valor (possui muito pouca variabilidade), o que não acrescenta informações relevantes ao modelo, ou uma que possua alguns dados faltantes (NA’s). O que podemos fazer nesses casos, que é o que iremos estudar neste capítulo, é realizar alterações em tais variáveis, afim de melhorar/otimizar a nossa predição/classificação. Essa é a ideia de pré-processar.

Padronizando os Dados

Vamos carregar o banco de dados spam e criar amostras treino e teste.

library(kernlab)

library(caret)

data(spam)

set.seed(123)

noTreino = createDataPartition(y = spam$type, p = 0.75, list = F)

treino = spam[noTreino,]

teste = spam[-noTreino,]

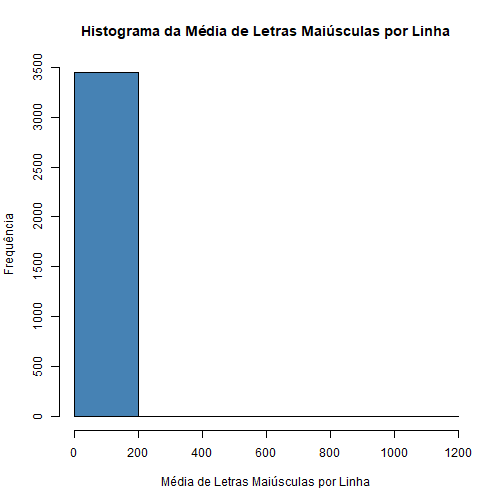

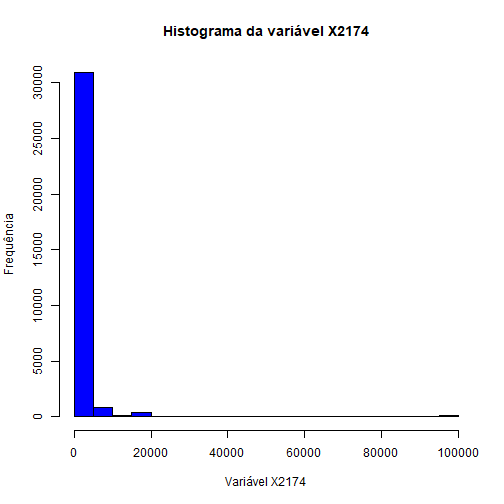

# Vamos olhar para a variável capitalAve (média de letras maiúsculas por linha):

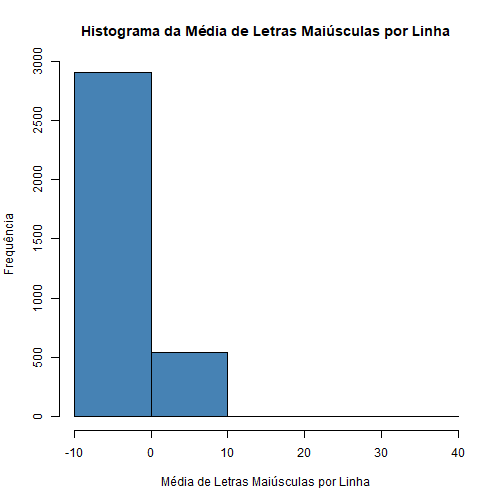

hist(treino$capitalAve,

ylab = "Frequência",

xlab = "Média de Letras Maiúsculas por Linha",

main = "Histograma da Média de Letras Maiúsculas por Linha",

col="steelblue", breaks = 4)

Podemos notar que muitos elementos estão próximos do 0 e os outros estão muito espalhados. Ou seja, essa variável não está trazendo muita informação para o modelo.

mean(treino$capitalAve)

## [1] 4.863991

sd(treino$capitalAve)

## [1] 27.80173

Podemos ver que a média é pequena mas o desvio padrão é muito grande.

Para que os algoritmos de machine learning não sejam enganados pelo fato de a variável ser altamente variável, vamos realizar um pré-processamento. Vamos padronizar os dados da variável pela amostra treino pegando cada valor dela e subtraindo pela sua média e dividindo pelo seu desvio padrão.

treinoCapAve = treino$capitalAve

# Padronizando a variável:

treinoCapAveP = (treino$capitalAve-mean(treinoCapAve))/sd(treinoCapAve)

# Média da variável padronizada:

mean(treinoCapAveP)

## [1] 0.000000000000000009854945

Agora temos média 0.

# Desvio padrão da variável padronizada:

sd(treinoCapAveP)

## [1] 1

E variância 1.

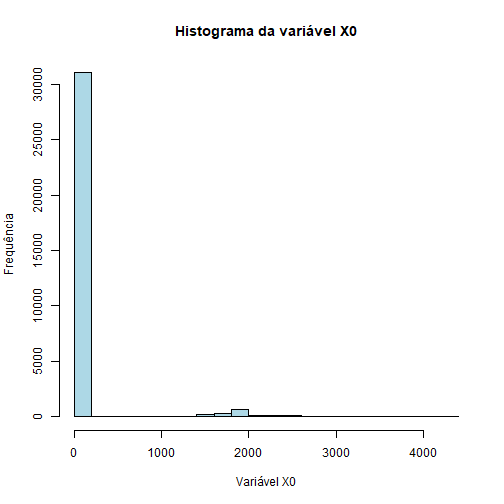

# Vamos olhar para a variável capitalAve (média de letras maiúsculas por linha):

hist(treinoCapAveP, ylab = "Frequência", xlab = "Média de Letras Maiúsculas por Linha",

main = "Histograma da Média de Letras Maiúsculas por Linha",col="steelblue", breaks =4)

Agora vamos aplicar a mesma transformação na amostra teste. Uma coisa a ter em mente é que ao aplicar um algoritmo no conjunto de teste, só podemos usar os parâmetros que estimamos no conjunto de treino. Ou seja, temos que usar a média e o desvio padrão da variável capitalAve do TREINO.

testeCapAve = teste$capitalAve

# Aplicando a transformação:

testeCapAveP = (testeCapAve-mean(treinoCapAve))/sd(treinoCapAve)

# Média da variável transformada do conjunto teste:

mean(testeCapAveP)

## [1] 0.04713308

# Desvio Padrão da variável transformada do conjunto teste:

sd(testeCapAveP)

## [1] 1.486708

Nesse caso não obtemos média 0 e variância 1, afinal nós utilizamos os parâmetros do treino para a padronização. Mas podemos notar que os valores estão relativamente próximos disso.

Padronizando os Dados com a Função preProcess()

Podemos realizar o pré-processamento utilizando a função preProcess() do caret. Ela realiza vários tipos de padronizações, mas para utilizarmos a mesma (subtrair a média e dividir pelo desvio padrão) utilizamos o método c(“center”,”scale”).

padronizacao = preProcess(treino, method = c("center","scale"))

# O comando acima cria um modelo de padronização. Para ter efeito ele deve ser aplicado nos dados com o

# comando predict().

treinoCapAveS = predict(padronizacao,treino)$capitalAve

# Média da variável padronizada:

mean(treinoCapAveS)

## [1] 0.000000000000000008680584

# Desvio padrão da variável padronizada:

sd(treinoCapAveS)

## [1] 1

Note que chegamos à mesma média e variância de quando padronizamos sem o preProcess().

Agora vamos aplicar essa padronização no conjunto de teste:

testeCapAveS = predict(padronizacao,teste)$capitalAve

# Note que aplicamos o modelo de padronização criado com a amostra treino.

Observe que também encontramos o mesmo valor da média e desvio padrão de quando padronizamos a variável do conjunto teste anteriormente (sem o preProcess()):

mean(testeCapAveS)

## [1] 0.04713308

sd(testeCapAveS)

## [1] 1.486708

Repare que também chegamos à mesma média e variância de quando padronizamos sem o preProcess().

preProcess como argumento da função train()

Também podemos utilizar o preProcess dentro da função train da seguinte forma:

modelo = train(type~., data = treino, preProcess = c("center","scale"),

method = "glm")

A única limitação é que esse método aplica a padronização em todas as variáveis numéricas.

Obs.: Quando for padronizar uma variável da sua base para depois treinar seu algoritmo, lembre-se que colocar a variável padronizada de volta na sua base.

Tratando NA’s

É muito comum encontrar alguns dados faltantes (NA’s) em uma base de dados. E quando você usa essa base para fazer predições, o algoritmo preditor muitas vezes falha, pois eles são criados para não manipular dados ausentes (na maioria dos casos). O mais recomendado a se fazer é descartar esses dados, principalmente se o número de variáveis for muito pequeno. Porém, em alguns casos, podemos tentar substituir os NA’s da amostra por dados de outros elementos que possuam características parecidas.

Obs: Este é um procedimento que deve ser feito com muito cuidado, apenas em situações de real necessidade.

Método k-Nearest Neighbors (knn)

O método k-Nearest Neighbors (knn) consiste em procurar os k vizinhos mais próximos do elemento que possui o dado faltante de uma variável de interesse, calculando a média dos valores observados dessa variável dos k vizinhos e imputando esse valor ao elemento.

Vamos utilizar novamente a variável capitalAve do banco de dados spam como exemplo.

library(kernlab)

library(caret)

data(spam)

set.seed(13343)

# Criando amostras treino e teste:

noTreino = createDataPartition(y = spam$type, p = 0.75, list = F)

treino = spam[noTreino,]

teste = spam[-noTreino,]

Originalmente, a variável capitalAve não possui NA’s. Mas para o objetivo de compreendermos como esse método funciona, vamos inserir alguns valores NA’s.

NAs = rbinom(dim(treino)[1], size = 1, p = 0.05)==1

O que fizemos com a função rbinom() é criar uma amostra de tamanho “dim(treino)[1]” (quantidade de elementos no treino) de uma variável Bernoulli com probabilidade de sucesso = 0,05. Ou seja, o vetor NAs será um vetor do tipo logical, onde será TRUE se o elemento gerado pela rbinom() é “1” (probabilidade de 0,05 de acontecer) e FALSE se é “0” (probabilidade 0,95 de acontecer).

Para preservar os valores originais, vamos criar uma nova coluna de dados no treino chamada capAve, que será uma réplica da variável capitalAve, mas com os NA’s inseridos em alguns valores.

library(dplyr)

# Criando a nova variável capAve com os mesmos valores da capitalAve:

treino = treino %>% mutate(capAve = capitalAve)

# Inserindo os Na's:

treino$capAve[NAs] = NA

Agora podemos aplicar o método KNN para imputar valores aos NA’s, escolhendo essa opção por meio do argumento “method” da função preProcess(). O padrão da função é utilizar k=5.

imput = preProcess(treino, method = "knnImpute")

# Aplicando o modelo de pré-processamento ao banco de dados treino:

treino$capAve = predict(imput,treino)$capAve

# Olhando para a variável capAve após o pré-processamento:

head(treino$capAve, n = 20)

## [1] -0.046596612 -0.008173931 0.125003949 -0.052792906 -0.052792906 -0.067986558 -0.105588726 -0.083548027 0.122825344

## [10] -0.115746121 -0.047388832 -0.093931771 -0.097100652 -0.021245565 0.850451334 -0.115519772 -0.044418006 -0.015445381

## [19] -0.120867259 0.001785409

Note que além de ter imputado valores aos NA’s, o comando knnImpute também padronizou os dados.

OBS: O método knnImpute só resolve os NA’s quando os dados faltantes são NUMÉRICOS.

E se quiséssemos aplicar o método de imputar valores aos NA’s em todo o conjunto de dados, e não só em apenas 1 variável? Também podemos fazer isso utilizando a função preProcess().

Vamos utilizar a base de dados “airquality”, já disponível no R, como exemplo.

base = airquality

head(base, n = 15)

## Ozone Solar.R Wind Temp Month Day

## 1 41 190 7.4 67 5 1

## 2 36 118 8.0 72 5 2

## 3 12 149 12.6 74 5 3

## 4 18 313 11.5 62 5 4

## 5 NA NA 14.3 56 5 5

## 6 28 NA 14.9 66 5 6

## 7 23 299 8.6 65 5 7

## 8 19 99 13.8 59 5 8

## 9 8 19 20.1 61 5 9

## 10 NA 194 8.6 69 5 10

## 11 7 NA 6.9 74 5 11

## 12 16 256 9.7 69 5 12

## 13 11 290 9.2 66 5 13

## 14 14 274 10.9 68 5 14

## 15 18 65 13.2 58 5 15

Note que essa base possui alguns valores NA’s em algumas variáveis.

# Realizando o método KNN para imputar valores aos NA's:

imput = preProcess(base, method = "knnImpute")

# Aplicando o modelo em toda a base de dados:

nova_base = predict(imput, base)

# Vamos olhar para a nova base:

head(nova_base, n = 15)

## Ozone Solar.R Wind Temp Month Day

## 1 -0.03423409 0.045176154 -0.72594816 -1.1497140 -1.407294 -1.6700195

## 2 -0.18580489 -0.754304874 -0.55563883 -0.6214670 -1.407294 -1.5572102

## 3 -0.91334473 -0.410083876 0.75006604 -0.4101682 -1.407294 -1.4444009

## 4 -0.73145977 1.410956244 0.43783226 -1.6779609 -1.407294 -1.3315917

## 5 -0.81027658 -0.221317522 1.23260914 -2.3118573 -1.407294 -1.2187824

## 6 -0.42831817 0.007422883 1.40291847 -1.2553634 -1.407294 -1.1059732

## 7 -0.57988897 1.255501599 -0.38532950 -1.3610128 -1.407294 -0.9931639

## 8 -0.70114561 -0.965279034 1.09068470 -1.9949091 -1.407294 -0.8803546

## 9 -1.03460136 -1.853591288 2.87893266 -1.7836103 -1.407294 -0.7675454

## 10 -0.64051729 0.089591767 -0.38532950 -0.9384152 -1.407294 -0.6547361

## 11 -1.06491552 0.749163615 -0.86787260 -0.4101682 -1.407294 -0.5419268

## 12 -0.79208809 0.778033763 -0.07309573 -0.9384152 -1.407294 -0.4291176

## 13 -0.94365889 1.155566471 -0.21502017 -1.2553634 -1.407294 -0.3163083

## 14 -0.85271641 0.977904020 0.26752293 -1.0440646 -1.407294 -0.2034991

## 15 -0.73145977 -1.342811742 0.92037537 -2.1005585 -1.407294 -0.0906898

Note que ela não possui mais NA’s e todas as variáveis foram padronizadas.

Utilizando Algoritmos de Machine Learning com o Pacote mlr

O pacote mlr fornece vários métodos de imputação para dados faltantes. Alguns desses métodos possuem técnicas padrões como, por exemplo, imputação por uma constante (uma constante fixa, a média, a mediana ou a moda) ou números aleatórios (da distribuição empírica dos dados em consideração ou de uma determinada família de distribuições). Para mais informações sobre como utilizar essas imputações padrões, consulte https://mlr.mlr-org.com/reference/imputations.html.

Entretanto, a principal vantagem desse pacote - que é o que abordaremos nessa seção - é a possibilidade de imputação dos valores faltantes de uma variável por meio de predições de um algoritmo de machine learning, utilizando como base as outras variáveis. Ou seja, além de aceitar valores faltantes de variáveis numéricas para a imputação, ele também aceita de variáveis categóricas.

Podemos observar todos os algoritmos de machine learning possíveis de serem utilizados nesse pacote através da função listLearners().

- Para um problema de imputação de NA’s de variáveis numéricas temos os seguintes métodos:

library(mlr)

knitr::kable(listLearners("regr", properties = "missings")["class"])

| class |

|---|

| regr.bartMachine |

| regr.cforest |

| regr.ctree |

| regr.cubist |

| regr.featureless |

| regr.gbm |

| regr.h2o.deeplearning |

| regr.h2o.gbm |

| regr.h2o.glm |

| regr.h2o.randomForest |

| regr.randomForestSRC |

| regr.rpart |

| regr.xgboost |

- Para um problema de imputação de NA’s de variáveis categóricas temos os seguintes métodos:

knitr::kable(listLearners("classif", properties = "missings")["class"])

| class |

|---|

| classif.bartMachine |

| classif.boosting |

| classif.C50 |

| classif.cforest |

| classif.ctree |

| classif.featureless |

| classif.gbm |

| classif.h2o.deeplearning |

| classif.h2o.gbm |

| classif.h2o.glm |

| classif.h2o.randomForest |

| classif.J48 |

| classif.JRip |

| classif.naiveBayes |

| classif.OneR |

| classif.PART |

| classif.randomForestSRC |

| classif.rpart |

| classif.xgboost |

Vamos utilizar o banco de dados “heart” para realizarmos a imputação de dados faltantes categóricos.

library(caret)

library(readr)

library(dplyr)

heart = read_csv("Heart.csv")

# Verificando se a base "heart" possui valores NA's em alguma variável:

apply(heart, 2, function(x) any(is.na(x)))

## X1 Age Sex ChestPain RestBP Chol Fbs RestECG MaxHR

## FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSE

## ExAng Oldpeak Slope Ca Thal HeartDisease

## FALSE FALSE FALSE FALSE FALSE FALSE

Note que a base não possui dados faltantes. Para fins didáticos, vamos inserir alguns na variável “Thal”.

# Criando um novo banco de dados que possuirá NA's:

new.heart = as.data.frame(heart)

set.seed(133)

# Criando um vetor do tipo *logical*, onde será TRUE se o elemento gerado pela rbinom() é "1"

# (probabilidade de 0,1 de acontecer):

NAs = rbinom(dim(new.heart)[1], size = 1, p = 0.1)==1

# Inserindo os NA's na variável Thal:

new.heart$Thal[NAs] = NA

new.heart$Thal

## [1] "fixed" "normal" "reversable" "normal" "normal" "normal" "normal" "normal"

## [9] "reversable" "reversable" "fixed" "normal" "fixed" "reversable" "reversable" "normal"

## [17] "reversable" "normal" "normal" "normal" NA "normal" "normal" "reversable"

## [25] "reversable" "normal" "normal" "normal" "normal" NA "normal" "reversable"

## [33] "normal" "reversable" "normal" "normal" "reversable" "fixed" "reversable" "normal"

## [41] "reversable" "reversable" "normal" "normal" "normal" "reversable" "normal" "reversable"

## [49] "normal" "normal" "normal" "reversable" "normal" "normal" "reversable" NA

## [57] "reversable" "reversable" "normal" "normal" NA "normal" "reversable" "normal"

## [65] NA "reversable" "normal" "reversable" "reversable" "normal" "normal" "reversable"

## [73] "reversable" "fixed" NA "normal" "reversable" "normal" "normal" NA

## [81] "normal" "normal" "normal" "reversable" "normal" "normal" "normal" "normal"

## [89] "normal" "normal" "reversable" "reversable" "normal" "normal" "reversable" "reversable"

## [97] "reversable" "normal" "normal" "normal" "normal" NA "normal" "reversable"

## [105] "reversable" "reversable" "reversable" "reversable" "reversable" "reversable" "normal" "fixed"

## [113] "reversable" "reversable" "fixed" "normal" "normal" "reversable" "reversable" "reversable"

## [121] "reversable" "normal" NA "normal" NA "reversable" "reversable" "normal"

## [129] "normal" "reversable" "reversable" "normal" "normal" "normal" "normal" NA

## [137] "reversable" "reversable" "normal" "normal" "reversable" "normal" "reversable" "reversable"

## [145] "normal" "reversable" "normal" "normal" NA "reversable" "normal" "reversable"

## [153] "reversable" "normal" "normal" "reversable" "reversable" NA "reversable" "reversable"

## [161] NA "normal" "normal" "normal" "reversable" "normal" NA "normal"

## [169] "reversable" "reversable" "normal" "normal" "fixed" "reversable" "reversable" "fixed"

## [177] "normal" "normal" "reversable" "reversable" "normal" "reversable" "normal" "normal"

## [185] "reversable" "fixed" "reversable" "reversable" "normal" "reversable" "normal" "normal"

## [193] "normal" "normal" "normal" "normal" "normal" "normal" "normal" NA

## [201] "reversable" NA "reversable" NA "reversable" "normal" "normal" "normal"

## [209] "reversable" "normal" "reversable" "normal" "reversable" "normal" "normal" "normal"

## [217] "normal" "normal" "normal" "normal" "reversable" "normal" "normal" "normal"

## [225] "normal" "normal" "normal" "normal" "normal" NA "normal" "normal"

## [233] "normal" "reversable" "reversable" "normal" "normal" "normal" "normal" "normal"

## [241] "normal" "normal" "normal" "reversable" "normal" "reversable" "normal" "fixed"

## [249] "reversable" "reversable" "normal" "normal" "normal" "normal" "normal" "normal"

## [257] "reversable" "normal" "normal" "normal" "normal" "normal" "fixed" "fixed"

## [265] "reversable" "normal" "reversable" "fixed" "reversable" "normal" "normal" "reversable"

## [273] "normal" "normal" "normal" "normal" "reversable" "normal" "reversable" NA

## [281] "reversable" "fixed" "fixed" "reversable" "normal" "reversable" "normal" "fixed"

## [289] "reversable" "normal" NA "fixed" NA "reversable" "reversable" "reversable"

## [297] "normal"

Agora vamos imputar categorias aos dados faltantes da variável Thal. Iremos fazer isso através da função impute(). O único problema é que possuímos variáveis do tipo character na base de dados, e a função não aceita esta classe nos dados.

str(new.heart)

## 'data.frame': 297 obs. of 15 variables:

## $ X1 : num 1 2 3 4 5 6 7 8 9 10 ...

## $ Age : num 63 67 67 37 41 56 62 57 63 53 ...

## $ Sex : num 1 1 1 1 0 1 0 0 1 1 ...

## $ ChestPain : chr "typical" "asymptomatic" "asymptomatic" "nonanginal" ...

## $ RestBP : num 145 160 120 130 130 120 140 120 130 140 ...

## $ Chol : num 233 286 229 250 204 236 268 354 254 203 ...

## $ Fbs : num 1 0 0 0 0 0 0 0 0 1 ...

## $ RestECG : num 2 2 2 0 2 0 2 0 2 2 ...

## $ MaxHR : num 150 108 129 187 172 178 160 163 147 155 ...

## $ ExAng : num 0 1 1 0 0 0 0 1 0 1 ...

## $ Oldpeak : num 2.3 1.5 2.6 3.5 1.4 0.8 3.6 0.6 1.4 3.1 ...

## $ Slope : num 3 2 2 3 1 1 3 1 2 3 ...

## $ Ca : num 0 3 2 0 0 0 2 0 1 0 ...

## $ Thal : chr "fixed" "normal" "reversable" "normal" ...

## $ HeartDisease: chr "No" "Yes" "Yes" "No" ...

## - attr(*, "spec")=

## .. cols(

## .. X1 = col_double(),

## .. Age = col_double(),

## .. Sex = col_double(),

## .. ChestPain = col_character(),

## .. RestBP = col_double(),

## .. Chol = col_double(),

## .. Fbs = col_double(),

## .. RestECG = col_double(),

## .. MaxHR = col_double(),

## .. ExAng = col_double(),

## .. Oldpeak = col_double(),

## .. Slope = col_double(),

## .. Ca = col_double(),

## .. Thal = col_character(),

## .. HeartDisease = col_character()

## .. )

Vamos transformar essas categorias em fatores.

new.heart = mutate_if(new.heart, is.character, as.factor)

Vamos separar os dados em treino e teste.

set.seed(133)

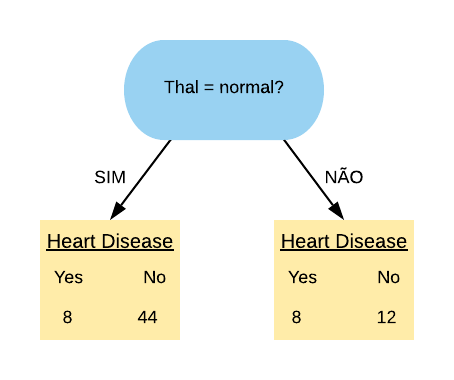

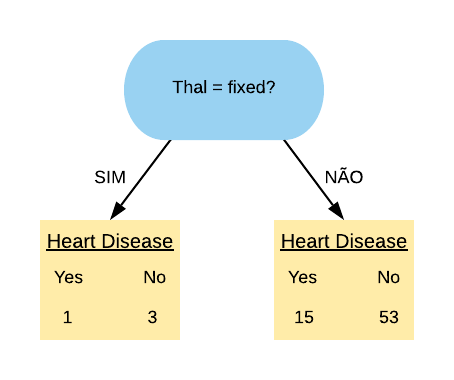

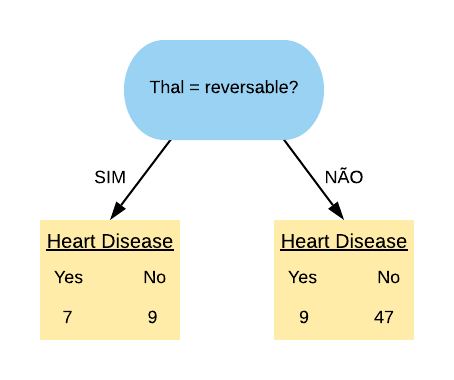

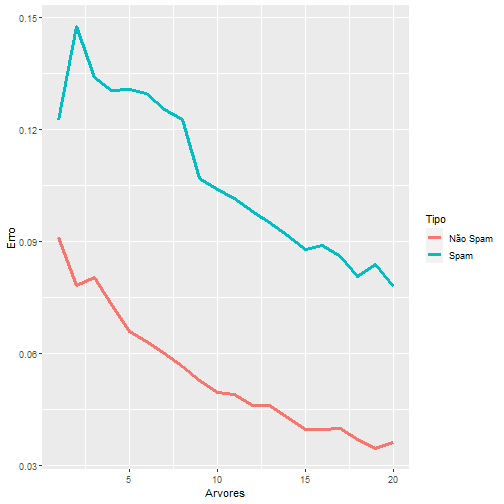

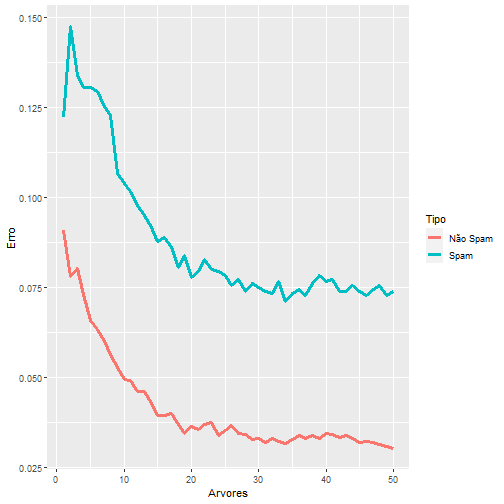

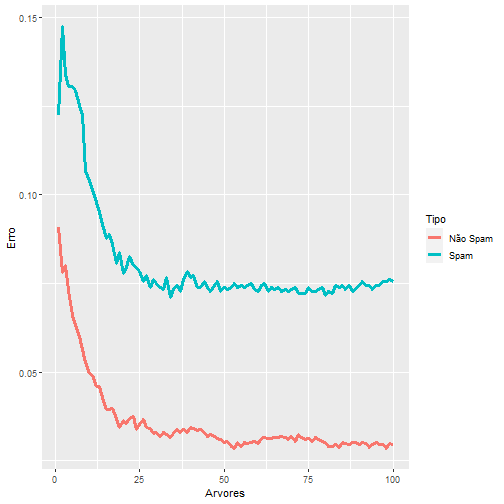

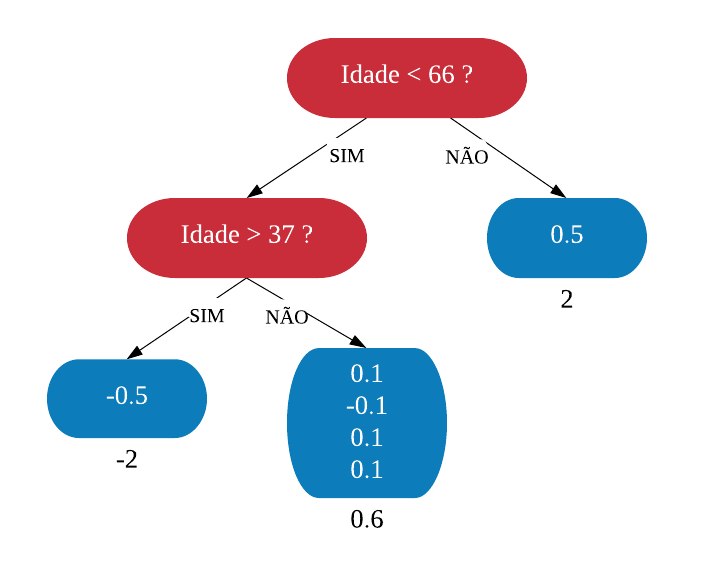

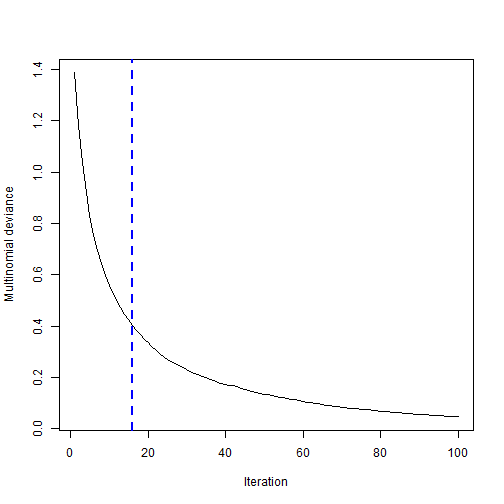

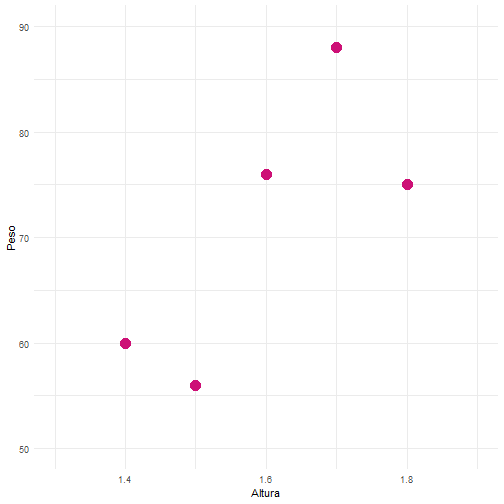

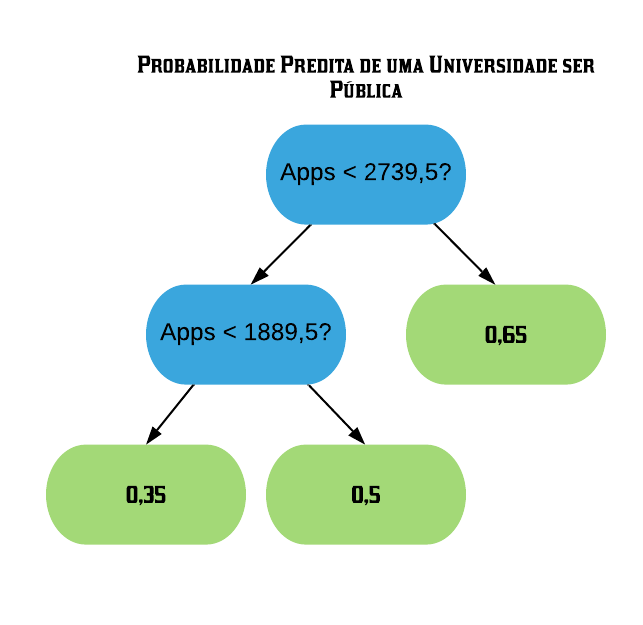

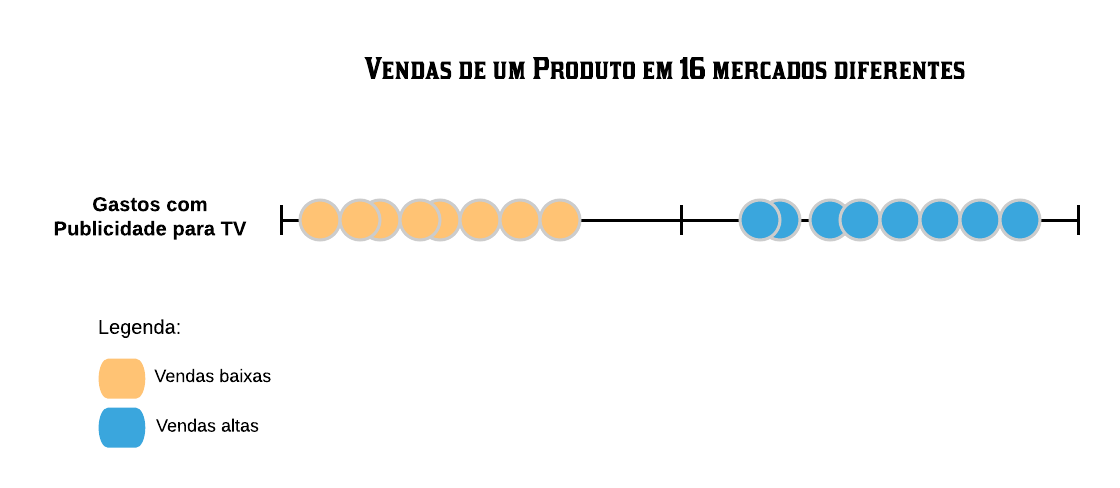

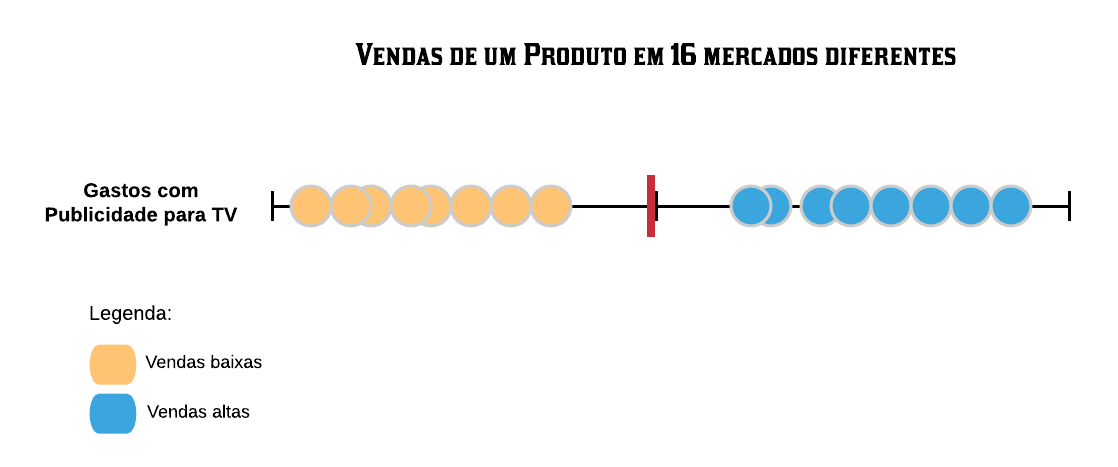

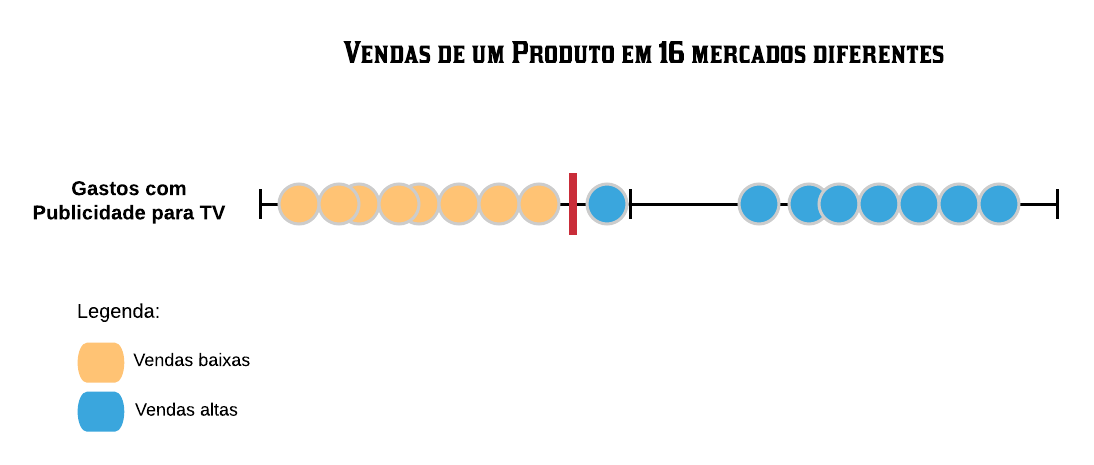

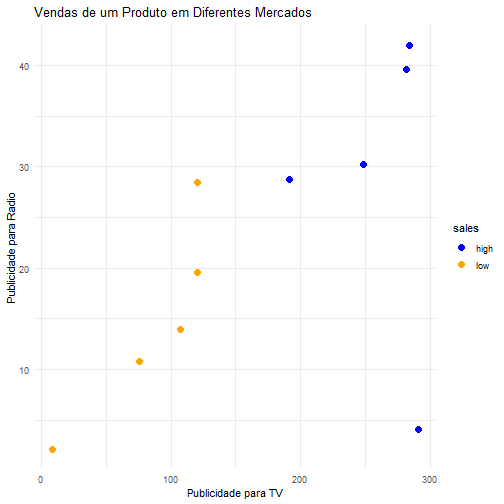

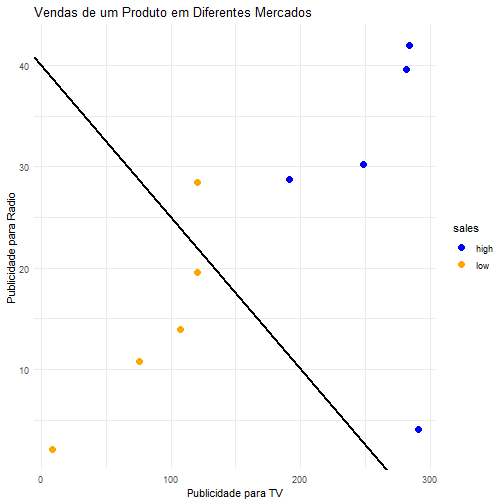

noTreino = caret::createDataPartition(y = new.heart$HeartDisease, p = 0.75,